Estudio de caso: las cámaras de alta velocidad derriban las barreras para la realidad mixta en tiempo real

Descubra cómo la compañía de transmisión en vivo del metaverso Condense Reality llevó su sistema de realidad mixta al siguiente nivel utilizando Emergent de alta velocidad cámaras GigE en su sistema de captura volumétrica. Los productos emergentes se utilizan principalmente en aplicaciones de deportes, entretenimiento y eventos en vivo del metaverso.

Imagínese poder pararse junto a su artista favorito durante un concierto único en la vida, o tener asientos reservados en la línea de 50 yardas para cada juego o la oportunidad de "correr" junto a jugadores estrella mientras cargan la portería durante un campeonato de liga. Ahora, imagine poder tener estas experiencias mientras está sentado en su sala de estar, regresando a casa después de un ajetreado día de trabajo o jugando el juego multijugador más reciente.

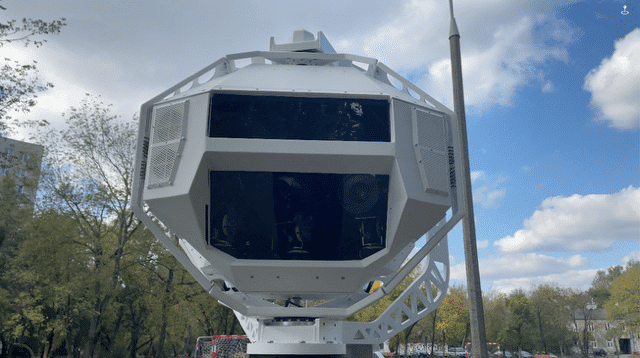

Las experiencias de "usted está allí" son lo que los medios inmersivos prometen ofrecer con la realidad mixta (MR) en tiempo real. Este nuevo formato utiliza datos de video volumétricos para crear imágenes tridimensionales (3D) a medida que ocurre un evento (Figura 1). Además, varias personas pueden ver las imágenes desde diferentes ángulos en una variedad de dispositivos.

Capturar la realidad en 3D es difícil

Las empresas de medios han sido las primeras en adoptar formatos tecnológicos como video de 360 grados, realidad virtual (VR), realidad aumentada (AR) y MR.

Regular, a diferencia del tiempo real, MR combina objetos físicos y digitales en 3D y generalmente se produce en espacios dedicados con pantallas verdes y cientos de cámaras calibradas con precisión. Procesar las cantidades masivas de datos volumétricos capturados en cada escena requiere horas o incluso días de tiempo de postproducción.

Intentar hacer MR en tiempo real ha demostrado ser aún más desafiante desde el punto de vista técnico y económico para los desarrolladores de contenido y, hasta ahora, ha hecho que el formato sea poco práctico.

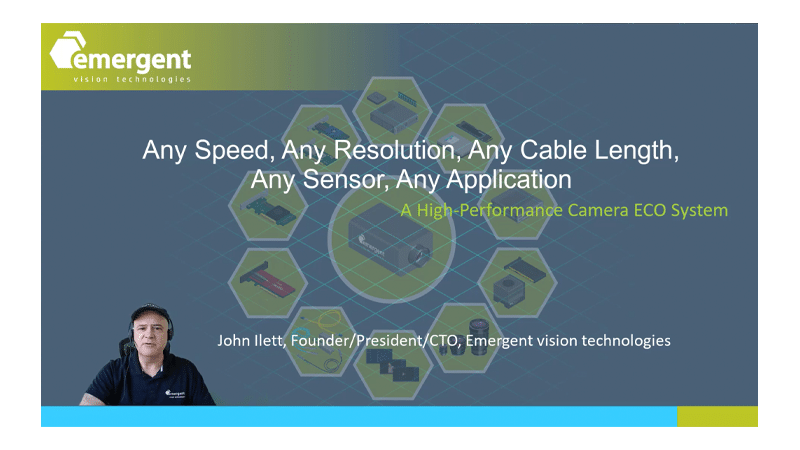

“Capturar y sincronizar video de alta resolución y alta velocidad de cuadros de una gran cantidad de cámaras por sí solo es lo suficientemente simple para nosotros”, dijo John Ilett, director ejecutivo y fundador de Emergent Vision Technologies, el principal fabricante de cámaras de imágenes de alta velocidad. . “Procesar este video en tiempo real en lugares en vivo ciertamente tiene sus desafíos”.

Figura 1: Condense Reality utiliza cámaras GigE Vision de alta velocidad de Emergent Vision Technologies para producir experiencias inmersivas de realidad mixta.

El aprendizaje profundo necesita una ayuda

Una startup pensó que tenía una estrategia para superar esos problemas. Condense Reality, una compañía de videos volumétricos, tenía un plan para capturar imágenes, reconstruir escenas y transmitir contenido de RM en múltiples resoluciones a los dispositivos de los usuarios finales. De principio a fin, cada cuadro en una transmisión en vivo requeriría solo milisegundos para completarse.

“Nuestro software calcula el tamaño y la forma de los objetos en la escena”, dijo el CEO de Condense Reality, Nick Fellingham (Figura 2). “Si hay algún objeto que las cámaras no pueden ver, el software utiliza el aprendizaje profundo para llenar los espacios en blanco y descartar lo que no se necesita, y luego transmite imágenes en movimiento en 3D a teléfonos, tabletas, computadoras, consolas de juegos, auriculares y dispositivos inteligentes. Televisores y anteojos.

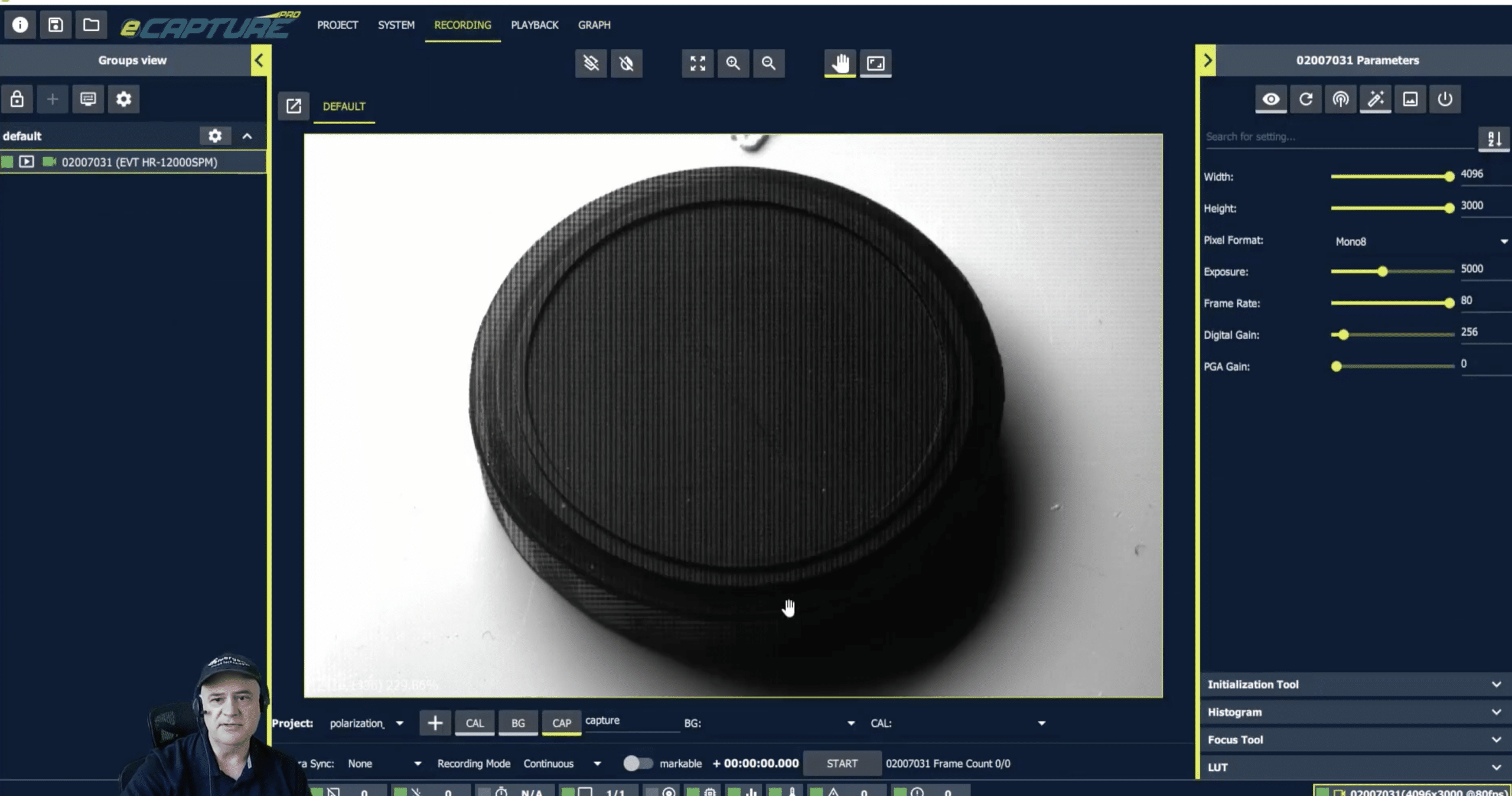

Pero hubo un problema. Para que el software funcionara en aplicaciones del mundo real, Fellingham necesitaba una cámara de alta resolución y alta velocidad de fotogramas que los creadores de contenido pudieran instalar fácilmente en un estadio deportivo, una sala de conciertos o una ubicación remota. La empresa probó las cámaras, pero los modelos utilizaron un rendimiento de datos muy limitado y la distancia del cable entre las cámaras y la unidad de procesamiento de datos del sistema. Para avanzar, Condense Reality necesitaba una cámara con calidad de transmisión que pudiera manejar datos volumétricos a altas velocidades.

Figura 2: El director ejecutivo de Condense Reality, Nick Fellingham, se para dentro de una de las configuraciones de captura volumétrica de la empresa.

Las cámaras de alta velocidad ofrecen

En 2020, Fellingham se enteró de que Emergent Vision Technologies estaba lanzando varias cámaras nuevas con sensores de imagen de alta resolución. Estas cámaras incluían modelos con SFP28-25GigE, QSFP28-50GigE y QSFP28-100GigE opciones de interfaz, todas las cuales ofrecen opciones de cableado para cubrir cualquier longitud.

“Nuestras cámaras brindan imágenes de calidad a altas velocidades y altas tasas de datos”, dijo Ilett. “Aprovechan los avances en la tecnología de sensores e incorporan el firmware que desarrollamos para que las cámaras puedan alcanzar la frecuencia de cuadro completa del sensor”.

Las imágenes en una experiencia de RM deben capturarse a una velocidad de fotogramas y una resolución extremadamente altas. Con las nuevas cámaras, Fellingham pudo ensamblar un sistema comercialmente viable. “Las cámaras GigE de alta velocidad son lo que necesitamos para obtener los datos de las cámaras rápidamente y transmitirlos”, señaló.

La captura de alta velocidad es particularmente importante para los deportes, donde la acción emocionante a menudo ocurre literalmente en un abrir y cerrar de ojos. Al capturar un swing de golf, por ejemplo, es probable que una cámara con una velocidad de fotogramas de 30 fps solo "vea" el principio y el final del swing, lo que reduce significativamente la calidad del contenido volumétrico.

“No estamos usando estas cámaras para inspeccionar piezas en una fábrica; los estamos usando para crear experiencias de entretenimiento”, dijo Fellingham. “Cuando aumenta la velocidad [fps], aumenta la calidad para la acción de movimiento rápido, el resultado que generamos es mejor y la experiencia mejora en general”.

Áreas de captura más grandes están en el horizonte

Condense Reality sirve como integrador de sistemas para proyectos de clientes. Un sistema estándar utiliza 32 cámaras, un conmutador de red de alta velocidad de Mellanox y una sola unidad de procesamiento de gráficos (GPU) de NVIDIA para cubrir una captura de 7 metros por 7 metros. La empresa trabajó con Emergent Vision Technologies para armar el sistema óptimo para la captura volumétrica.

“No necesariamente queremos comprometernos con configuraciones de hardware muy específicas, pero al trabajar con el equipo de Emergent y probar diferentes componentes, descubrimos que NVIDIA y Mellanox funcionan mejor para nosotros”, dijo Fellingham.

Junto con la implementación de su tecnología, la empresa está trabajando para aumentar el área de captura de RM manteniendo el rendimiento y la calidad.

“Cuando comienzas a crecer más de un área de 10 por 10 metros, las cámaras 4K no son suficientes”, dijo Fellingham. “Cuando nuestros algoritmos mejoren, seremos más grandes”.

Las nuevas cámaras de Emergent Vision Technologies son parte integral de este trabajo. Con modelos de apoyo hasta fps 600 con una resolución de 5120 x 4096 y opciones de interfaz que van hasta 100 GigE, Fellingham no ha tenido que preocuparse por los límites en la resolución de la cámara, las velocidades de datos o las velocidades de fotogramas. Esas ventajas significan que Condense Reality está bien posicionado para ofrecer contenido y experiencias de usuario aún mejores.

Software: La salsa secreta

El software de Condense Reality es una oferta completamente patentada que crea una malla 3D compuesta por cientos de miles de polígonos. Los nodos colocados en un objeto representan la superficie del objeto que se captura. Luego, el software “pinta” la malla con los datos adquiridos por las cámaras. Luego, estos datos utilizan el aprendizaje profundo para estimar las partes del objeto que las cámaras no cubrieron. Luego, los algoritmos de compresión reducen la malla al tamaño más pequeño posible para cada cuadro, dijo Fellingham.

“El software toma todos estos datos y los convierte en un modelo 3D a un ritmo extremadamente rápido, y solo puede hacerlo gracias a los algoritmos bien optimizados, las redes neuronales y las GPU de NVIDIA”, dijo. “Si bien la mayoría de las redes neuronales se basan en TensorFlow, algunas de las que usamos en el sistema deben ejecutarse muy rápido, por lo que están escritas directamente para la GPU”.

Agregó: “Nuestras redes neuronales resuelven problemas muy específicos, lo que ayuda a optimizarlas para la velocidad. No desplegamos una enorme caja negra que realiza un montón de inferencias, ya que esto sería muy difícil de optimizar”.

Para finalizar el proceso, los datos se envían a la plataforma de distribución basada en la nube de Condense Reality, que toma los datos y los coloca en una tasa de bits variable para que la transmisión sea diferente según el dispositivo del usuario. La reproducción ocurre dentro de un motor de juego, lo que permite a los clientes crear experiencias personalizadas, que podrían ser VR o AR, en torno al video volumétrico. Debido a que los sistemas Condense Reality admiten motores de juegos, su contenido también se puede transmitir a mundos de juegos existentes propiedad de otras compañías. Actualmente, el software es compatible con los motores de juego Unity y Unreal, pero la compañía planea crear complementos para su software para cualquier nuevo motor de juego que surja en el futuro.

“Estos motores ya casi no se pueden llamar motores de juegos, ya que son herramientas 3D realmente interactivas”, dijo Fellingham. “Dirigimos el contenido del mundo real a estas herramientas para brindar a los clientes experiencias interactivas 3D fotorrealistas”.

PARA MAYOR INFORMACIÓN

Cámaras de alta velocidad de Emergent Vision Technologies:

https://emergentvisiontec.com/area-scan-cameras/