Portal tecnológico

Portal tecnológico

Anatomía de un sistema de visión artificial

General

Aunque el componente principal de cada sistema de visión artificial es una cámara, ningún sistema de visión artificial está completo sin todos los siguientes componentes:

- Iluminación

- Lente

- Cámara

- Cableado

- Periféricos de interfaz

- Plataformas informáticas

- Software

Cada componente de un sistema de visión artificial juega un papel importante en el cumplimiento del propósito general del sistema, que es ayudar a las máquinas a tomar mejores decisiones observando el mundo exterior. El cumplimiento de este propósito requiere el posicionamiento ordenado de los componentes de manera que se pueda facilitar el flujo de información desde la captura de la luz hasta la entrega y el procesamiento de una imagen digital.

La siguiente imagen muestra el posicionamiento de cada componente. Cada componente mencionado en la imagen se analiza en detalle a continuación.

Iluminación

Cuando una cámara captura una imagen de un objeto, lo que realmente está haciendo es capturar la luz que el objeto ha reflejado. El grado en que la luz es absorbida o reflejada depende de la superficie del objeto, ya sea transparente, translúcido u opaco.

Para asegurarse de que la cámara pueda capturar todos los detalles necesarios para el análisis, los sistemas de visión artificial deben estar equipados con la iluminación adecuada. Hay varias técnicas disponibles para diseñar la iluminación en un sistema de visión artificial en función de la posición, el ángulo, la naturaleza reflectante y el espectro de color de la fuente de luz. Estos son:

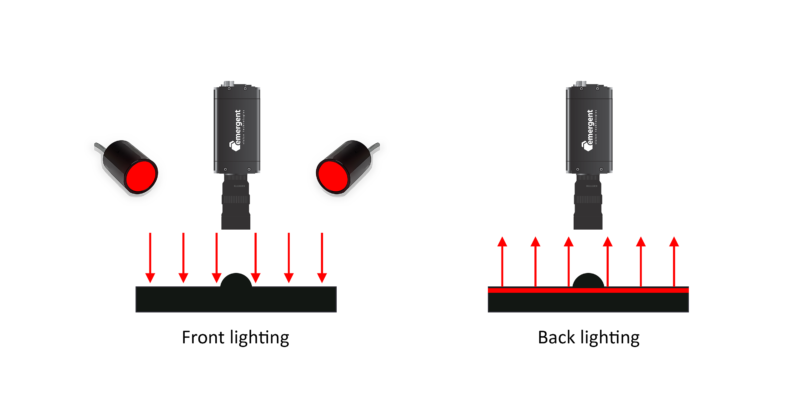

- Técnicas de iluminación basadas en la posición

- Iluminación frontal – Tanto la cámara como la fuente de luz miran hacia la escena de destino desde el mismo lado.

- Iluminación trasera – La cámara y la fuente de luz se colocan una frente a la otra con la escena de destino en el medio.

- Iluminación frontal – Tanto la cámara como la fuente de luz miran hacia la escena de destino desde el mismo lado.

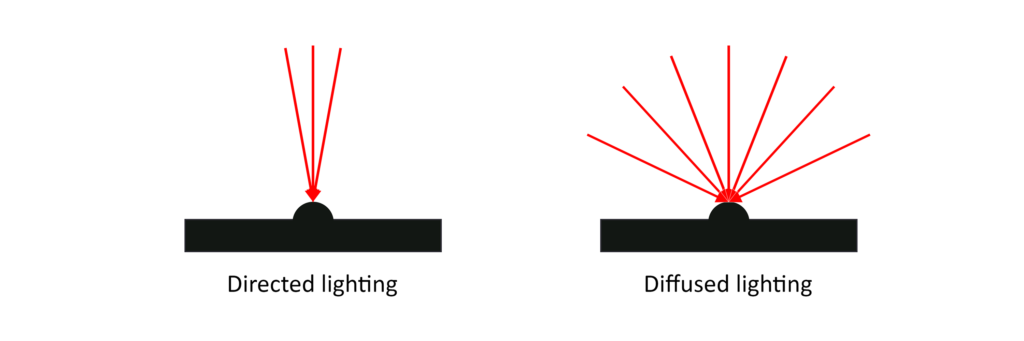

- Técnicas de iluminación basadas en ángulos

-

- Iluminación dirigida – Un solo rayo de luz o un grupo de rayos distribuidos en un ángulo muy estrecho ilumina todos los puntos de la escena de destino. La iluminación dirigida proyecta sombras fuertes y hace que la textura se destaque en la imagen.

- Iluminación difusa – Los rayos de luz distribuidos en ángulos amplios iluminan todos los puntos de la escena objetivo. La iluminación difusa arroja poca o ninguna sombra, lo que elimina las sombras y hace que la textura sea más evidente.

- Iluminación dirigida – Un solo rayo de luz o un grupo de rayos distribuidos en un ángulo muy estrecho ilumina todos los puntos de la escena de destino. La iluminación dirigida proyecta sombras fuertes y hace que la textura se destaque en la imagen.

-

-

- Iluminación difusa axial – Un divisor de haz refleja la luz difusa hacia abajo sobre el objetivo, lo que da como resultado una iluminación uniforme.

-

-

-

- Iluminación de cúpula difusa – Un espejo en forma de hemisferio refleja la luz difusa hacia abajo iluminando el objetivo.

-

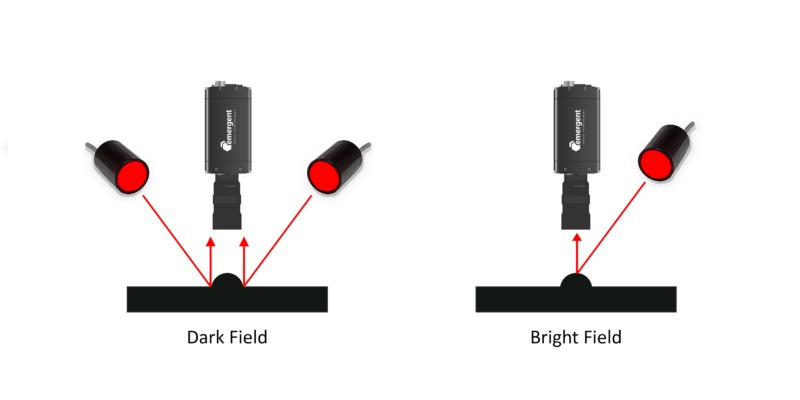

- Técnicas de iluminación basadas en la naturaleza reflectante

-

- Iluminación de campo oscuro – La fuente de luz se coloca de manera que su luz no se refleje en un espejo ni se transmita directamente al campo de visión de la cámara.

-

- Iluminación de campo brillante – La fuente de luz se coloca de tal manera que se espera que su luz se refleje en un espejo o se transmita directamente al campo de visión de la cámara.

- Técnica de iluminación basada en patrones

- iluminación estructurada – En el caso de la luz estructurada, un patrón de luz, como puntos, cuadrículas o una forma más compleja, se proyecta en ángulo sobre un objeto.

- Técnicas de iluminación basadas en el espectro de colores.

-

- Iluminación RGB – Para las imágenes monocromáticas, la luz suele ser una banda estrecha de longitudes de onda, ya sea roja, verde o azul.

-

- Iluminación blanca – Para obtener imágenes en color, se necesita luz blanca.

- Técnicas de iluminación basadas en el espectro de luz.

-

- iluminación ultravioleta - El ultravioleta (UV) es un espectro de longitudes de onda más cortas (200nm a 400nm) que las de la luz visible (400nm a 780nm). En el caso de la iluminación UV, se utiliza una fuente que emite luz UV para iluminar un objeto.

-

- iluminación SWIR – El espectro infrarrojo de onda corta (SWIR) (900 nm a 2,500 nm) es la región de luz infrarroja (780 nm y 1 mm) más cercana a la luz visible. En el caso de la iluminación SWIR, se utiliza una fuente que emite luz SWIR para iluminar un objeto.

-

- iluminación NIR – Las longitudes de onda del infrarrojo cercano (NIR) están en el rango de 780-1400 nm. En el caso de la iluminación NIR, se utiliza una fuente que emite luz NIR para iluminar un objeto.

Lente

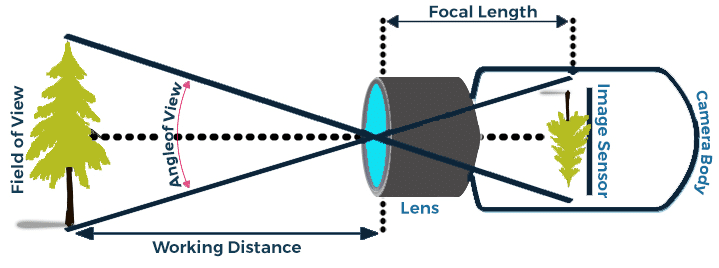

Una lente es un dispositivo que magnifica una escena enfocando la luz que entra a través de ella. En palabras simples, una lente permite que la cámara vea claramente el mundo exterior. Una escena vista por la cámara se considera como enfocado si los bordes parecen afilados y fuera de foco si los bordes aparecen borrosos. Es importante tener en cuenta aquí que las lentes utilizadas en las cámaras de visión artificial a menudo tienen un enfoque fijo o un enfoque ajustable, mientras que las lentes utilizadas en las cámaras de consumo, por ejemplo, las cámaras DSLR y Point & Shoot, tienen enfoque automático. Ángulo de visión (AoV), Campo de visión (FoV), Distancia del objeto, distancia focal, apertura y F-Stop son algunos de los términos que se utilizan a menudo al clasificar las lentes. A continuación se muestra una breve explicación de estos términos:

- Ángulo de visión (AoV)

El ángulo de visión (AoV) se refiere a la extensión angular de un área (en grados) que se puede ver a través de la lente. AoV es una especificación de todas las lentes que se deriva al enfocar una lente al infinito mientras se usa un tamaño de sensor compatible. Para una lente dada y un tamaño de sensor, AoV es constante.

- Campo de visión (FoV)

El campo de visión (FoV) se refiere a la extensión rectangular de un área que se puede ver a través de la lente, pero el FoV depende de la distancia focal y la distancia del objeto. FoV describe lo que se captura a una distancia focal específica en lugar de enfocar la lente al infinito en el caso de AoV.

- Distancia del objeto

La distancia del objeto es la distancia de trabajo entre la lente y el objeto de destino.

- Longitud focal

La distancia focal es la distancia entre la lente y el punto focal. Cuando el punto focal está en el sensor, la imagen está enfocada.

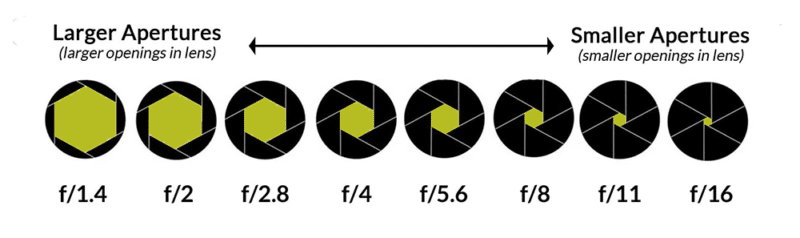

- Apertura y F-Stop

La apertura es la abertura de la lente que controla la cantidad de luz que llega al sensor. El tamaño de la apertura se mide por su valor F-stop. Un valor alto de F-stop significa una apertura de apertura pequeña, y viceversa.

tipos de lentes

1. Lente entocéntrica/endocéntrica – Estos lentes vienen con una distancia focal fija y son los lentes más comunes que se usan en las cámaras de visión artificial.

2. Lente macro - Los lentes macro están diseñados para lograr grandes aumentos y, por lo general, funcionan en el rango de aumentos de 05x a 10x.

3. Lente telecéntrica - Los lentes telecéntricos no tienen un ángulo de imagen y crean una vista perpendicular de la escena.

Cámara

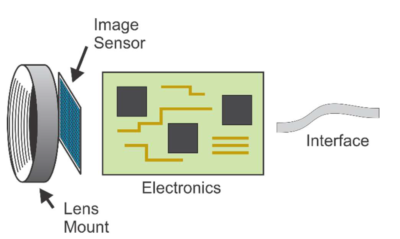

Una caja protectora que contiene una montura de lente, un sensor de imagen, un procesador, electrónica de potencia y una interfaz de comunicación es lo que se conoce como cámara en visión artificial.

En el núcleo de cualquier cámara se encuentra un sensor de imagen que convierte la luz entrante (fotones) en señales eléctricas (electrones). Un sensor de imagen se compone de exposición de matrices llamadas “fotodiodos” que actúan como un pozo de potencial donde la energía electromagnética de los fotones se convierte en microvoltaje. Luego, este voltaje se pasa a un Convertidor de analógico a digital (ADC) que genera un valor digital. Los sensores de imagen disponibles en el mercado se pueden clasificar en función de la estructura física (CCD/CMOS), las dimensiones de los píxeles (Exploración de área/Exploración de línea), el tipo de croma (Color/Mono), el tipo de obturador (Global/Rolling), el espectro de luz ( UV/SWIR/NIR) y polarización de la luz.

Cada fotodiodo en un sensor corresponde a un píxel de una imagen digital. Mientras que un fotodiodo está asociado con el valor analógico, un píxel de imagen está asociado con el valor digital. Un píxel es el elemento más pequeño de una imagen digital y es una abreviatura de 'elemento de imagen'. La resolución, la intensidad, la exposición, la ganancia y la velocidad de fotogramas son algunos de los conceptos básicos relacionados con la imagen digital que se analizan a continuación.

Conceptos de imagen digital

- Resolución - Una imagen digital está formada por píxeles. La resolución de imagen es una medida del número de columnas de píxeles y filas de píxeles en una imagen. Una resolución de imagen de 1280 x 1024 nos dice que la imagen mide 1280 píxeles de ancho y 1024 píxeles de alto.

- Intensidad – El brillo de un píxel de imagen se llama intensidad. Cuanto mayor sea la profundidad de bits de un ADC, mayor será el rango para expresar la intensidad. Por ejemplo, si la profundidad de bits de un ADC es de 8 bits, solo hay 2⁸ o 256 (0 a 255) valores disponibles para expresar la intensidad. Sin embargo, si la profundidad de bits de un ADC es de 12 bits, ahora hay 2¹² o 4096 valores disponibles para expresar la intensidad.

- Exposición - La exposición se refiere a la duración del tiempo durante el cual un fotodiodo está expuesto a la luz. El tiempo de exposición normalmente se mide en microsegundos (µs) y milisegundos (ms).

- Ganancia - La ganancia es la amplificación de los valores de intensidad de los píxeles. Cuando la fuerza de la carga del fotodiodo aumenta en el sensor, se denomina ganancia analógica y cuando el valor del píxel aumenta después de que la carga se haya convertido en un valor digital, se denomina ganancia digital.

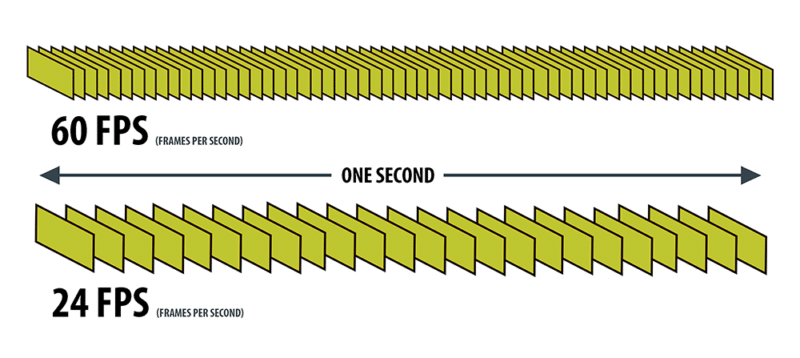

- Cuadros por segundo - Velocidad de fotogramas medida en fotogramas por segundo o FPS, es la cantidad de imágenes que un sensor puede generar en un segundo.

Cableado

Ethernet

Ethernet es una tecnología de Red de Área Local (LAN) que fue introducida en 1983 por el Instituto de Ingenieros Eléctricos y Electrónicos (IEEE) como el estándar 802.3. IEEE 802.3 define la especificación para el control de acceso al medio (MAC) de la capa física y la capa de enlace de datos. Ethernet es una tecnología cableada que admite cableado de cobre de par trenzado (BASE-T) y cableado de fibra óptica (BASE-R). Las siguientes tablas a continuación mencionan varias tecnologías de red Ethernet en función de su velocidad y tipo de cable/transceptor.

| Estándares Ethernet BASE-T basados en cableado de cobre de par trenzado |

|---|

| Nombre | Velocidad | Tipo de cable | Max. Longitud del cable |

|---|---|---|---|

| 1000BASE-T | 1 Gbps | Cat5e Cat6 |

100 m |

| 10GBASE-T | 10 Gbps | Cat6A Cat7 Gato xnumxa |

100 m |

| Estándares Ethernet BASE-R basados en cableado de fibra óptica |

|---|

| Nombre | Velocidad | Tipo de transceptor | Max. Longitud del cable |

|---|---|---|---|

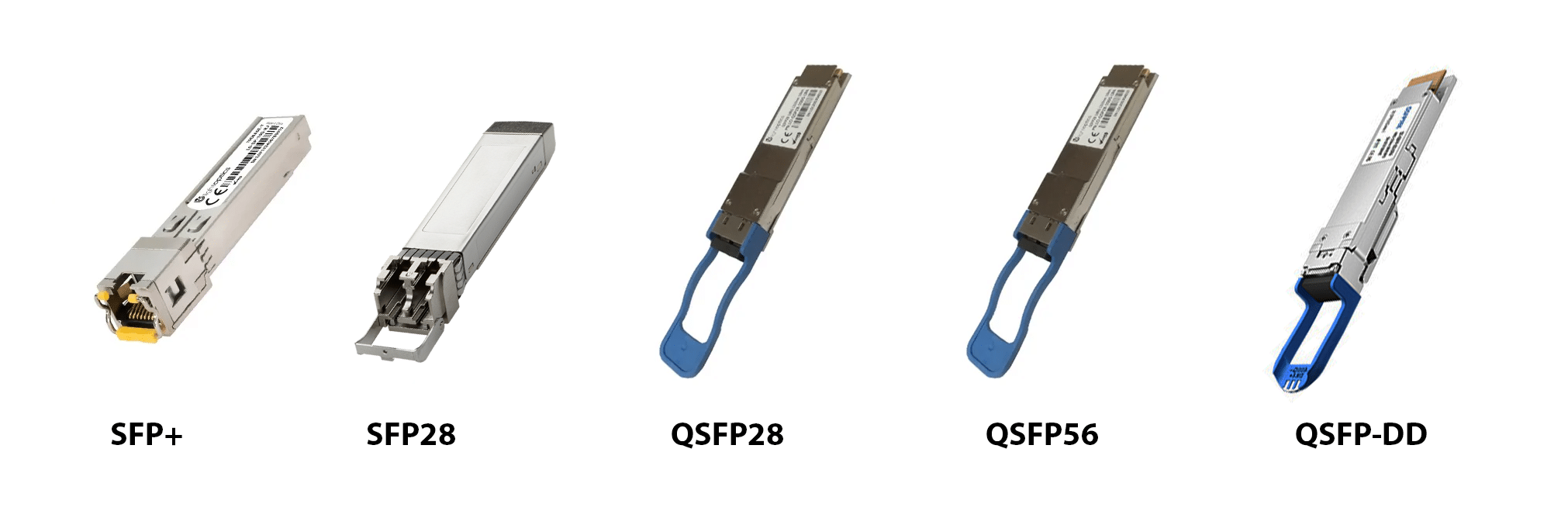

| 10GBASE-R | 10 Gbps | SFP+ (1 carril) | 80 kilómetros (ZR) |

| 25GBASE-R | 25 Gbps | SFP28 (1 carril) | 80 kilómetros (ZR) |

| 50GBASE-R | 50 Gbps | QSFP28 (2 carriles) SFP56 (1 carril) |

80 kilómetros (ZR) |

| 100GBASE-R | 100 Gbps | QSFP28 (4 carriles) SFP56 (2 carriles) SFP-DD (2 carriles) |

80 kilómetros (ZR) |

| 200GBASE-R | 200 Gbps | QSFP56 (4 carriles) QSFP-DD (4 carriles) |

80 kilómetros (ZR) |

| 400GBASE-R | 400 Gbps | QSFP56 (8 carriles) QSFP-DD (8 carriles) |

80 kilómetros (ZR) |

Bus serie universal (USB)

El estándar Universal Serial Bus (USB) se lanzó por primera vez en 1996 y es mantenido por el USB Implementers Forum (USB-IF). USB fue diseñado para estandarizar la conexión de periféricos a computadoras personales. USB puede comunicarse y suministrar energía eléctrica a periféricos como teclados, mouse, cámaras de video e impresoras. La siguiente tabla menciona varios estándares USB y sus velocidades.

| Estándares USB |

|---|

| Nombre | Velocidad | Longitud máxima del cable |

|---|---|---|

| USB 2.0 | 480 Mbps | 5 m |

| USB 3.0 | 5 Gbps | 3 m |

| USB 3.1 Gen 1 | 5 Gbps | 3 m |

| USB 3.1 Gen 2 | 10 Gbps | 3 m |

| USB 3.2 (2 x 3.1 generación 1) | 10 Gbps | 3 m |

| USB 3.2 (2 x 3.1 generación 2) | 20 Gbps | 3 m |

| USB 4 | 40 Gbps | 0.8 m |

CoaXPress

CoaXPress (CXP) es un estándar de comunicación punto a punto para transmitir datos a través de un cable coaxial. El estándar CoaXPress se presentó por primera vez en el Vision Show de 2008 en Stuttgart y actualmente lo mantiene la JIIA (Japan Industrial Imaging Association). La siguiente tabla menciona varios estándares CXP.

| Estándares CoaXPress |

|---|

| Nombre | Velocidad | Max. Longitud del cable |

|---|---|---|

| CXP-1 | 1.25 Gbps | 212 m |

| CXP-6 | 6.25 Gbps | 60 m |

| CXP-12 | 12.5 Gbps | 40m |

| CXP sobre fibra | 10 Gbps | 80 kms |

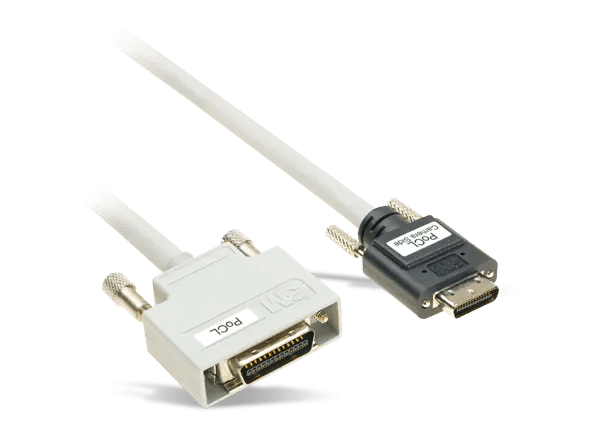

Enlace de cámara

Camera Link es un protocolo de gran ancho de banda creado para la comunicación paralela. Estandariza la conexión entre cámaras y capturadores de fotogramas. Camera Link High-Speed (CLHS) evolucionó a partir de Camera Link y se introdujo por primera vez en 2012. Ofrece señales en tiempo real de baja latencia y baja fluctuación entre una cámara y un capturador de fotogramas y puede transportar tanto la imagen como los datos de configuración utilizando tanto para cableado de cobre como de fibra.

| Estándares de enlace de cámara |

|---|

| Nombre | Velocidad | Max. Longitud del cable |

|---|---|---|

| Base de enlace de cámara | 2.04 Gbps | 10 m |

| Enlace de cámara lleno | 5.44 Gbps | 10 m |

| Deca de enlace de cámara | 6.80 Gbps | 10 m |

| Camera Link HS (alta velocidad) | 25 Gbps | 80 kms |

Periféricos de interfaz

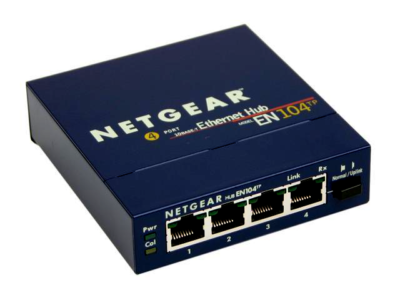

Ethernet

- Tarjeta de interfaz de red (NIC) – Una red ethernet tarjeta de interfaz (NIC) es una tarjeta de expansión que se conecta a la placa base de una computadora a través de una ranura PCIe e implementa el circuito electrónico para la capa física y la capa de enlace de datos del modelo de interconexión de sistemas abiertos (modelo OSI).

- interruptores - Un conmutador de red conecta dispositivos Ethernet dentro de la misma red de área local (LAN). Cuando un conmutador recibe un paquete de uno de los dispositivos conectados a sus puertos físicos, el conmutador lee su encabezado, luego hace coincidir la dirección o direcciones de destino y envía el paquete a través de los puertos apropiados a los dispositivos de destino. Las siguientes son algunas de las funciones de la cámara de visión artificial que requieren el uso de un interruptor:

-

- Multiplexación: en sistemas de múltiples cámaras de alta velocidad (por ejemplo, sistemas de 64 cámaras), donde cada cámara emite grandes cantidades de datos de píxeles, se requieren conmutadores para consolidar los datos de píxeles provenientes de múltiples puertos Ethernet y enviarlos a un servidor o PC host usando un solo puerto.

-

- Multidifusión: las aplicaciones de visión artificial que utilizan multidifusión requieren un interruptor para enviar datos de la cámara a varias PC anfitrionas.

-

- Protocolo de tiempo de precisión (PTP): un interruptor es un requisito si las marcas de tiempo de varias cámaras deben sincronizarse con el reloj de un solo dispositivo.

- Protocolo de tiempo de precisión (PTP): un interruptor es un requisito si las marcas de tiempo de varias cámaras deben sincronizarse con el reloj de un solo dispositivo.

- Concentradores Ethernet – Un concentrador también puede conectar varios dispositivos con el fin de compartir recursos, y la colección de dispositivos conectados a un concentrador se conoce como segmento LAN. Un concentrador se diferencia de un conmutador en que los paquetes enviados desde uno de los dispositivos conectados se transmiten a todos los dispositivos que están conectados al concentrador. Con un conmutador, los paquetes se dirigen solo al puerto que conduce al dispositivo direccionado.

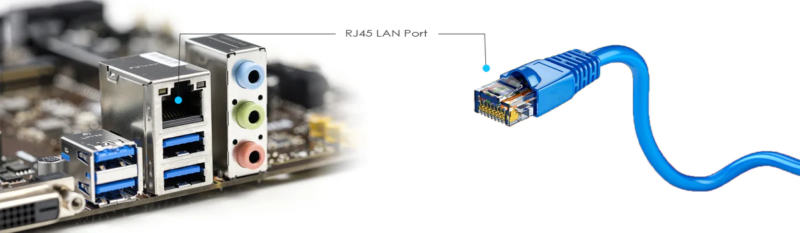

- Puertos Ethernet residentes en la placa base – Actualmente, todas las placas base tienen puertos Ethernet incorporados que admiten principalmente velocidades de 1 Gbps y, en algunos casos, también pueden admitir velocidades de 5 Gbps y 10 Gbps. Los puertos Ethernet integrados en una placa base no se recomiendan para aplicaciones de alta velocidad debido a su tamaño de búfer interno limitado y rendimiento limitado.

Bus serie universal (USB)

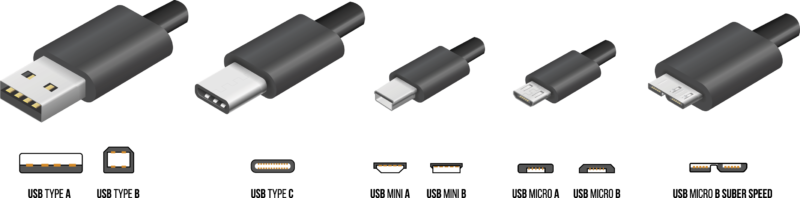

- Tarjetas USB PCIe – Las tarjetas USB son tarjetas de expansión basadas en PCIe que se utilizan para aumentar la cantidad de puertos USB en una PC. Hay una variedad de tarjetas USB disponibles en el mercado compatibles con varios estándares USB como USB 2.0 y USB 3.0 y compatibles con varios conectores USB como USB-A, USB-B, USB-C y Micro-USB.

- Concentradores de puertos USB – Los concentradores USB son dispositivos externos que se conectan a una computadora mediante un conector USB macho y tienen puertos USB hembra disponibles. Los concentradores USB agregan puertos USB adicionales a su computadora, para que pueda conectar dispositivos USB adicionales.

- Puertos USB residentes en la placa base: La mayoría de las placas base en estos días vienen con puertos USB 3.0 incorporados y algunas placas base aún admiten USB 2.0 y USB 3.0.

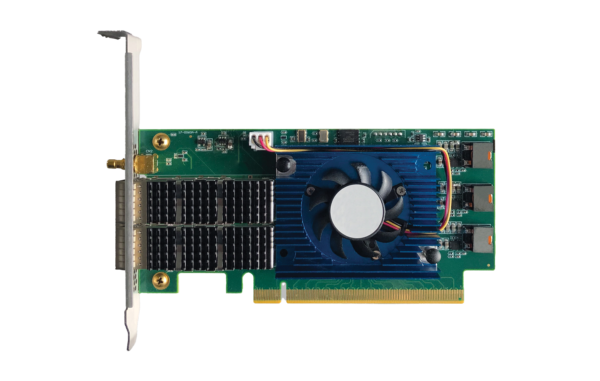

CoaXPress

- Capturadores de fotogramas – Los capturadores de fotogramas de CoaXPress "toman" fotogramas individuales de una cámara y habilitan una variedad de capacidades de procesamiento de imágenes y adquisición de alto nivel, como la compresión en tiempo real y la capacidad de descargar Regiones de interés (ROI) para la utilización de ancho de banda adicional.

Enlace de cámara y CLHS

- Capturadores de fotogramas – Al igual que los capturadores de fotogramas de CoaXPress, los capturadores de fotogramas de Camera Link "toman" fotogramas individuales de una cámara e incluyen varias capacidades de procesamiento integradas, como regiones de interés programables, diezmado de píxeles, escalado de imágenes y tablas de búsqueda.

Plataformas informáticas

El procesador dentro de una cámara de visión artificial suele ser un procesador integrado o un Matriz de puerta programable en campo (FPGA) que ejecuta un firmware específico del modelo. Este firmware es responsable de leer los valores de píxeles del sensor de imagen, implementar funciones del sensor de imagen, procesar datos de píxeles para crear una imagen completa, aplicar algoritmos de mejora de imagen y comunicarse con dispositivos externos para generar una imagen completa.

El procesador dentro de una cámara es constreñido a minimizar el consumo de energía yd reducir la generación de calor. Como resultado, tiene una capacidad de procesamiento limitada cuando se trata de manejar velocidades de cuadro muy altas y generar imágenes posprocesadas al mismo tiempo. Para posprocesar grandes cantidades de datos de imagen provenientes de un sensor de velocidad de fotogramas muy alta, se prefiere enviar estos datos a un sistema externo para su procesamiento en lugar de utilizar los recursos del procesador de la cámara. Los diversos sistemas utilizados en el posprocesamiento de imágenes son:

- PC de consumo - Los sistemas basados en PC de consumo son las opciones más flexibles y económicas, ya que Los componentes disponibles en el mercado se pueden utilizar para diseñar un sistema. Las cámaras de visión artificial se pueden conectar con sistemas basados en PC mediante interfaces como Ethernet, USB, CoaXpress y Camera Link.

- PC industriales - Las PC industriales son Construido en una carcasa resistente para brindar protección contra el polvo y la suciedad. Estas PC pueden soportar golpes, vibraciones y temperaturas extremas en el entorno industrial. De manera similar a las PC de consumo, las cámaras también se pueden conectar a PC industriales mediante interfaces como Ethernet, USB, CoaXpress y Camera Link.

- Controladores de visión – Los controladores de visión también son sistemas basados en PC, pero además de la funcionalidad de PC, también ofrecen soporte para dispositivos seriales y de E/S. Los controladores de visión vienen con interfaces seriales y de E/S integradas, como puertos RS232/RS485, E/S analógica y E/S digital. Las interfaces seriales y de E/S permiten una integración más sencilla con los controladores lógicos programables (PLC) y los módulos de la serie C de comunicación industrial y permiten la implementación de protocolos de comunicación como Modbus serial. Algunos controladores de visión también tienen una función PWM para controlar la iluminación. La mayoría de los controladores de visión tienen puertos Ethernet y USB para conectar cámaras de visión artificial.

- Sistemas embebidos - Los sistemas integrados son computadoras altamente configurables que están diseñadas para que puedan integrarse en otros sistemas más grandes, como vehículos autónomos, drones y dispositivos médicos. Dado que estos sistemas integrados también admiten las mismas interfaces estándar como Ethernet y USB, se pueden conectar fácilmente con cámaras de visión artificial. Algunos ejemplos de sistemas embebidos son NVIDIA Jetson Orin y NVIDIA Jetson Xavier.

- PC de estación de trabajo - Las estaciones de trabajo que usan procesadores como AMD Threadripper PRO o Intel i9 son la opción preferida para construir un sistema de múltiples cámaras cuando se trata de equilibrar el rendimiento con el costo.

- Servidores empresariales – Los servidores empresariales que utilizan procesadores como AMD EPYC e Intel Xeon no solo pueden gestionar la distribución de datos de píxeles desde sistemas multicámara de alta velocidad a nodos de procesamiento, sino que también ofrecen un rendimiento excepcional para cargas de trabajo de procesamiento de imágenes.

- Sistemas basados en la nube – Dado que la complejidad de las aplicaciones de visión artificial está aumentando, por ejemplo, con el uso de inteligencia artificial, incluso los sistemas basados en PC no pueden cumplir con los requisitos de procesamiento en algunos casos. Aquí es donde las plataformas de procesamiento basadas en la nube como AWS, Azure y Google Cloud están llenando el vacío, ya que brindan amplios recursos para escalar el procesamiento.

Software

Mientras que una cámara de visión artificial es responsable de capturar una imagen y enviarla a la PC anfitriona, el software de imágenes que se ejecuta en la PC anfitriona es responsable de:

-

- Interfaz con el hardware de la cámara

- Controlar las funciones de la cámara

- Recepción, procesamiento y análisis de imágenes.

- Realización de la toma de decisiones utilizando resultados de imágenes.

- Comunicarse con cualquier otro dispositivo o máquina conectado que necesite entrada de cámara

Las tres categorías de software de imágenes en visión artificial son:

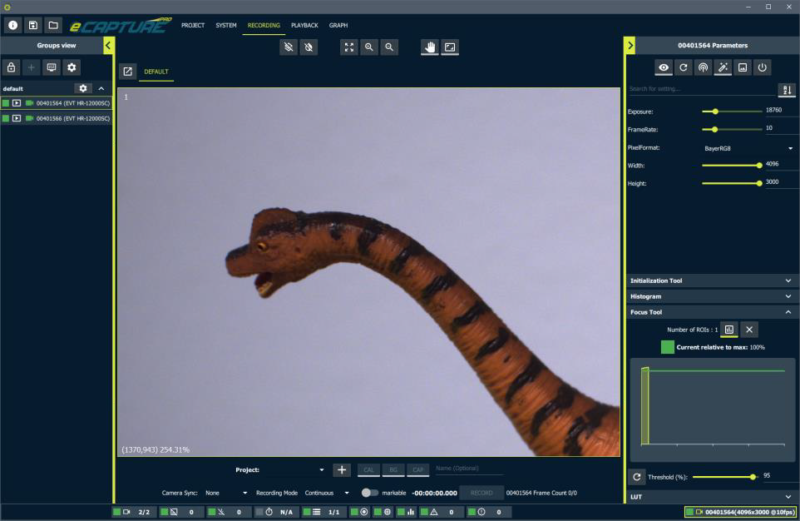

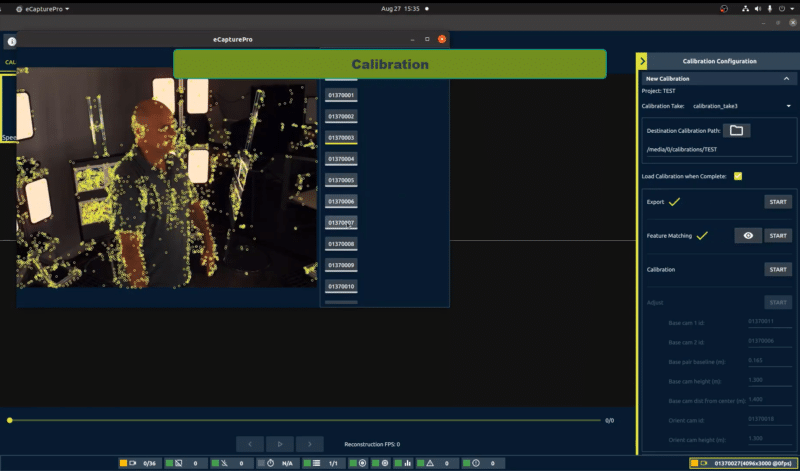

- Visor de cámara – Visor de cámara es la parte más fácil de usar e interactiva del software de imágenes, lo que hace que sea más fácil empezar a usar una cámara rápidamente. Además de las funciones de configuración de red, configuración de cámaras, captura de imágenes, mejora, visualización y grabación, algunos software de imágenes también ofrecen herramientas avanzadas para analizar imágenes, como histogramas y gráficos de líneas.

- Software Integral – Además de todas las características de un Camera Viewer, un Software Integral ofrece funciones avanzadas como gestión de proyectos, configuración multicámara, configuración multiservidor, compatibilidad con GPU, reconstrucción de imágenes 3D y visor de objetos 3D.

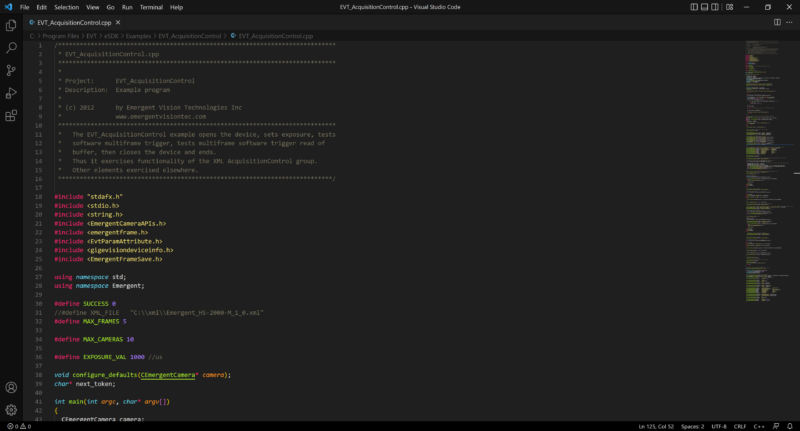

- Kit de desarrollo de software (SDK) – SDK es una colección de ejemplos de código, bibliotecas de código, interfaz de programación de aplicaciones (API), documentación y compiladores/depuradores, etc. La mayoría de los SDK de visión artificial son compatibles con los lenguajes de programación C/C++/C#/Python y se pueden usar para desarrollar aplicaciones personalizadas para Windows, Linux y plataformas ARM.