ケース スタディ: ハイスピード カメラがリアルタイムの複合現実の障壁を打ち破る

メタバース ライブ ストリーミング企業の Condense Reality が、Emergent 高速を使用して複合現実システムを次のレベルに引き上げた方法をご覧ください GigE カメラ そのボリューム キャプチャ システムで。 Emergent 製品は、主にメタバース スポーツ、エンターテイメント、およびライブ イベント アプリケーションで使用されています。

一生に一度のコンサートで、お気に入りのパフォーマーの隣に立つことができることを想像してみてください。あるいは、すべてのゲームで 50 ヤード ラインの座席を予約したり、リーグチャンピオンシップでスター プレーヤーがゴールを狙っているときに、その横で「走る」チャンスがあることを想像してみてください。そして、リビング ルームに座っているとき、仕事で忙しい 1日を終えて家に帰るとき、または最新のマルチプレイヤー ゲームをプレイしているときに、これらの体験ができることを想像してみてください。

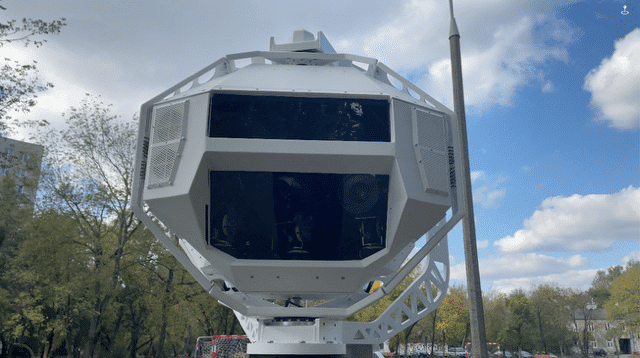

そこにいるような体験、それは没入型メディアがリアルタイムの複合現実 (MR) で提供を約束するものです。 この新しい形式は、ボリュメトリック ビデオ データを使用して、イベントの発生時に 3 次元 (1D) 画像を作成します (図 XNUMX)。 さらに、複数の人がさまざまなデバイスでさまざまな角度から画像を見ることができます。

3D で現実を捉えるのは難しい

メディア企業は、360 度ビデオ、バーチャル リアリティ (VR)、拡張現実 (AR)、MR などのテクノロジ フォーマットを早期に採用してきました。

リアルタイムではなく通常の MR は、物理オブジェクトとデジタル オブジェクトを 3D でブレンドし、通常はグリーン スクリーンと何百もの正確に調整されたカメラを備えた専用スペースで作成されます。 各シーンでキャプチャされた大量のボリューム データを処理するには、ポストプロダクションに数時間または数日かかることもあります。

リアルタイムで MR を実行しようとすることは、コンテンツ開発者にとって技術的および経済的にさらに困難であることが証明されており、これまでのところ、この形式は実用的ではありません。

「多数のカメラから高解像度、高フレームレートのビデオをキャプチャして同期することは、私たちにとって十分に簡単です。」高速イメージング カメラのトップ メーカーである Emergent Vision Technologies の CEO 兼創設者である John Ilett は述べています。「ライブ会場でこのビデオをリアルタイムで処理することには、確かに課題があります。」

図 1: Condense Reality は、Emergent Vision Technologies の高速 GigE Vision カメラを使用して、没入型の複合現実体験を生み出します。

ディープラーニングには支援が必要

あるスタートアップは、これらの問題を克服するための戦略があると考えていました。 ボリューメトリック ビデオ会社である Condense Reality は、画像をキャプチャし、シーンを再構成し、MR コンテンツを複数の解像度でエンド ユーザー デバイスにストリーミングする計画を立てていました。 ライブ ストリームの各フレームは、最初から最後まで数ミリ秒で完了する必要がありました。

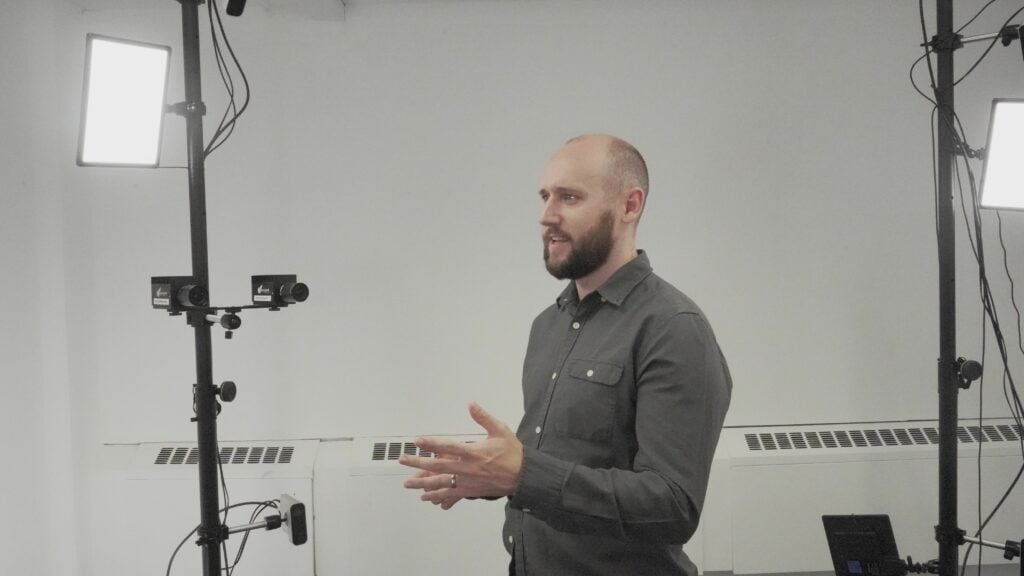

「当社のソフトウェアは、シーン内のオブジェクトのサイズと形状を計算します」と、Condense Reality の CEO、Nick Fellingham 氏は述べています (図 2)。 「カメラが認識できないオブジェクトがある場合、ソフトウェアはディープ ラーニングを使用して空白を埋め、不要なものを破棄し、3D モーション イメージを電話、タブレット、コンピューター、ゲーム コンソール、ヘッドセット、スマートテレビとスマートグラスにストリーミングします。」

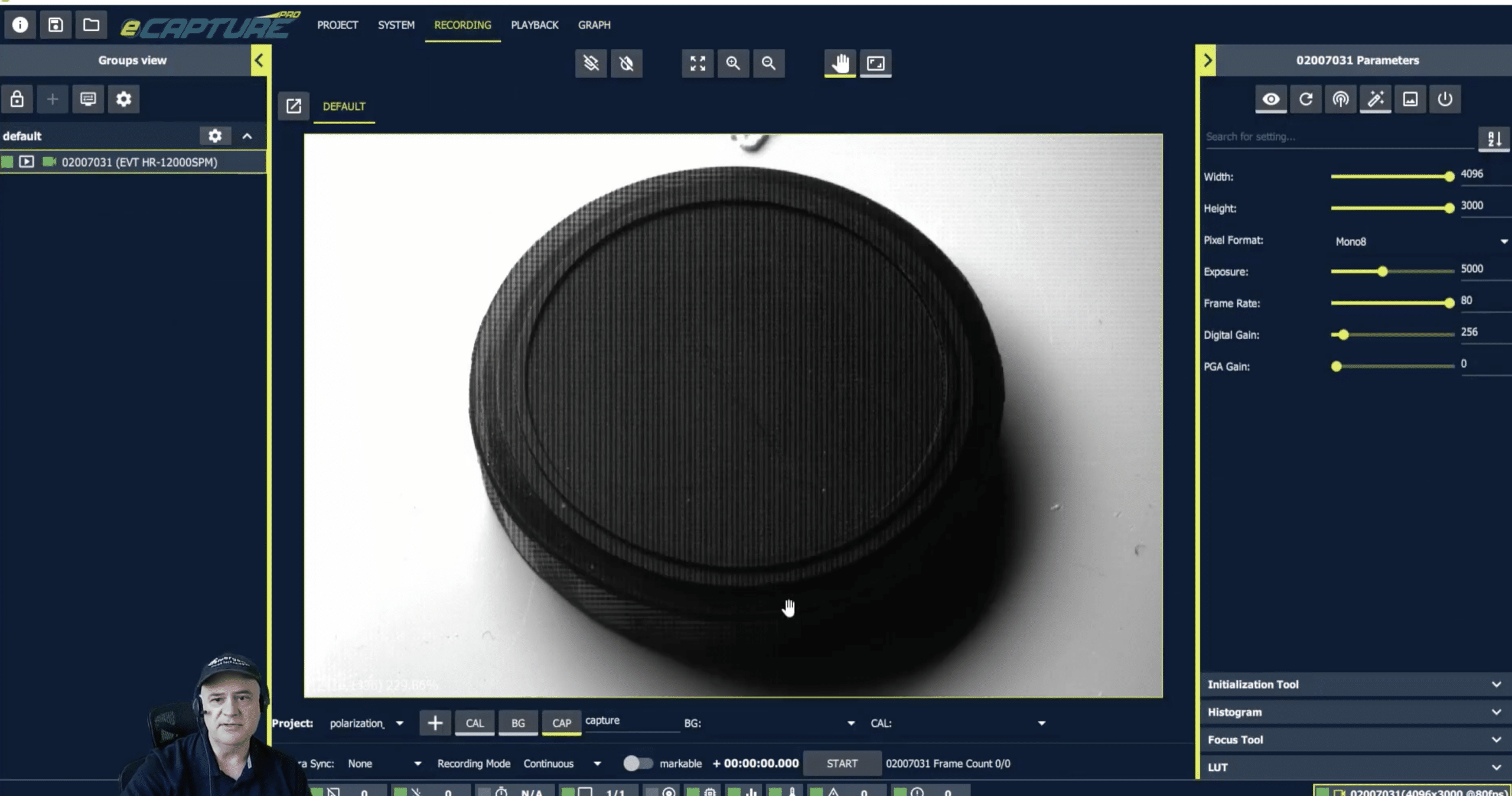

しかし、問題がありました。 ソフトウェアが実際のアプリケーションで機能するために、Fellingham 氏は、コンテンツ クリエーターがスポーツ スタジアム、コンサート会場、または遠隔地に簡単に設置できる、高解像度、高フレーム レートのカメラを必要としていました。 同社はカメラをテストしましたが、モデルのデータ スループットと、カメラとシステムのデータ処理ユニット間のケーブル距離が大幅に制限されていました。 前進するために、Condense Reality は、ボリューム データを高速で処理できる放送品質のカメラを必要としていました。

図 2: Condense Reality の CEO である Nick Fellingham は、同社のボリューメトリック キャプチャ セットアップの XNUMX つの内部に立っています。

高速カメラが実現

2020 年、Fellingham 氏は、Emergent Vision Technologies が高解像度のイメージ センサーを搭載した新しいカメラをいくつかリリースしていることを知りました。 これらのカメラには、 SFP28-25GigE、QSFP28-50GigE、および QSFP28-100GigE これらはすべて、あらゆる長さをカバーするケーブル オプションを提供します。

「当社のカメラは、高品質の画像を高速かつ高データ レートで提供します」と Ilett 氏は述べています。 「彼らはセンサー技術の進歩を利用し、私たちが開発したファームウェアを組み込んで、カメラがセンサーのフル フレーム レートを達成できるようにします。」

MR エクスペリエンスの画像は、非常に高いフレーム レートと解像度でキャプチャする必要があります。 新しいカメラを使用して、Fellingham は商業的に実行可能なシステムを組み立てることができました。 「高速 GigE カメラは、カメラからデータをすばやく取得してストリーミングするために必要なものです」と彼は述べています。

高速キャプチャは、エキサイティングなアクションが文字通り瞬く間に発生することが多いスポーツでは特に重要です。 たとえば、ゴルフ スイングをキャプチャする場合、フレーム レートが 30 fps のカメラでは、スイングの開始と終了しか「見えない」可能性が高く、ボリューム コンテンツの品質が大幅に低下します。

「これらのカメラは、工場での部品の検査には使用していません。 私たちはそれらを使ってエンターテインメント体験を作成しています」とFellingham氏は述べています。 「速度 [fps] が上がると、動きの速いアクションの品質が向上し、生成される出力が向上し、エクスペリエンスが全体的に向上します。」

より大きなキャプチャエリアがすぐそこに

Condense Reality は、顧客プロジェクトのシステム インテグレーターです。 標準システムでは、32 台のカメラ、Mellanox の高速ネットワーク スイッチ1台、および NVIDIA の 7 つのグラフィックス プロセッシング ユニット (GPU) を使用して、7 メートル x XNUMX メートルのキャプチャをカバーします。 同社は、Emergent Vision Technologies と協力して、ボリューム キャプチャに最適なシステムをまとめました。

「必ずしも特定のハードウェア構成にこだわりたいわけではありませんが、Emergent チームと協力してさまざまなコンポーネントをテストした結果、NVIDIA と Mellanox が最適であることがわかりました」と Fellingham 氏は述べています。

同社は技術の実装とともに、スループットと品質を維持しながらMRのキャプチャ領域を増やすことに取り組んでいます。

「10 x 10 メートルの領域よりも大きくなり始めると、4K カメラでは対応できません」とFellingham氏は言います。 「我々のアルゴリズムが向上すると、より大きな領域へと向かいます。」

新しい Emergent Vision Technologies カメラは、この作業に不可欠です。 対応機種あり 最大600 fps 5120 x 4096 の解像度と最大 100 GigE のインターフェイス オプションにより、Fellingham 氏はカメラの解像度、データ レート、またはフレーム レートの上限について心配する必要がありませんでした。 これらの利点は、Condense Reality がさらに優れたコンテンツとユーザー エクスペリエンスを提供できる位置にあることを意味します。

ソフトウェア: 秘密のソース

Condense Reality のソフトウェアは、数十万のポリゴンで構成される 3D メッシュを作成する完全に独占的な製品です。 オブジェクトに配置されたノードは、キャプチャされるオブジェクトの表面を表します。 次に、ソフトウェアは、カメラによって取得されたデータでメッシュを「ペイント」します。 次に、このデータはディープ ラーニングを使用して、カメラがカバーしなかったオブジェクトの部分を推定します。 圧縮アルゴリズムは、フレームごとにメッシュを可能な限り小さいサイズに縮小します、とFellingham氏は述べています。

「このソフトウェアは、このすべてのデータを取得し、非常に速いペースで 3D モデルに変換します。これを行うことができるのは、適切に最適化されたアルゴリズム、ニューラル ネットワーク、および NVIDIA GPU のおかげです」と彼は言いました。 「ほとんどのニューラル ネットワークは TensorFlow に基づいていますが、システムで使用する一部のものは非常に高速に実行する必要があるため、GPU 用に直接記述されています。」

彼は次のように付け加えました。「我々のニューラル ネットワークは非常に特定の問題を解決するので、その事は速度を最適化する際に役立ちます。最適化が非常に難しいため、大量の推論を実行する巨大なブラック ボックスは実装しません。」

プロセスを完了するために、データは Condense Reality のクラウドベースの分散プラットフォームに送信されます。この分散プラットフォームはデータを取得し、ユーザー デバイスに依存した可変ビットストリームに変換します。再生はゲーム エンジン内で行われ、顧客はボリューム ビデオを中心に VR や AR などのカスタム エクスペリエンスを構築できます。 Condense Reality システムはゲーム エンジンをサポートしているため、そのコンテンツを他社が所有する既存のゲーム ワールドにストリーミングすることもできます。 現在、このソフトウェアは Unity と Unreal のゲーム エンジンをサポートしていますが、同社は、将来登場する新しいゲーム エンジン用のソフトウェアのプラグインを構築する予定です。

「これらのエンジンは、本当にインタラクティブな 3D ツールであるため、もはやゲーム エンジンとは呼べません」と Fellingham 氏は述べています。 「現実世界のコンテンツをこれらのツールにルーティングして、写真のようにリアルな 3D のインタラクティブな体験を顧客に提供します。」

詳細については

Emergent Vision Technologies の高速カメラ:

https://emergentvisiontec.com/area-scan-cameras/