INDUSTRIELLE KI: WIE DEEP LEARNING MACHINE-VISION-SYSTEME ERGÄNZT

Im Bereich der industriellen Automatisierung ist künstliche Intelligenz (KI) zu einem echten Schlagwort geworden. Abgesehen vom Hype hat sich KI eine Nische im industriellen Bereich erobert und bietet bei richtiger Konzeption und Implementierung einen enormen Mehrwert in der Fertigungshalle. Deep Learning – eine Teilmenge der KI, die neuronale Netze wie Convolutional Neural Networks (CNNs) nutzt, die den Lernprozess des menschlichen Gehirns nachahmen – hat sich aufgrund seiner Fähigkeit, subjektive Inspektionsentscheidungen und die Inspektion von Szenen zu unterstützen, zu einem beliebten industriellen KI-Werkzeug entwickelt bei denen sich die Identifizierung spezifischer Merkmale aufgrund hoher Variabilität oder Komplexität als schwierig erweist.

Wenn es darum geht, eine Deep-Learning-Lösung auszuwählen, haben Hersteller mehrere Möglichkeiten, einschließlich der internen Programmierung einer Lösung und der Nutzung etablierter Frameworks wie PyTorch oder TensorFlow. Hersteller haben zudem die Möglichkeit, eine Standardlösung zu erwerben oder sich für ein anwendungsspezifisches KI-fähiges System oder Produkt zu entscheiden.

Deep Learning ist jedoch keine eigenständige Technologie. Eher, wenn sie neben herkömmlichen eingesetzt werden Bildverarbeitung Techniken wird es zu einem leistungsstarken Werkzeug für die automatisierte Inspektion, das die Gesamtfähigkeiten industrieller Automatisierungssysteme verbessert, die in Anwendungen wie der Elektronik- und Halbleiterinspektion, der Inspektion von Konsumgütern und der Automobilinspektion eingesetzt werden.

Anwendungen

DEEP LEARNING: EIN WERKZEUG FÜR DIE MASCHINE-VISION-WERKZEUGKASTEN

Machine Vision bezieht sich auf eine Reihe von Hardware – einschließlich Kameras, Optik und Beleuchtung – dazu noch das Passende Software., unterstützt Unternehmen bei der Ausführung bestimmter Funktionen basierend auf der Bildanalyse des Bildverarbeitungssystems. Die vier Hauptkategorien von Bildverarbeitungsanwendungen sind Inspektion, Identifizierung, Führung und Messung. Das Herzstück aller Systeme ist die Software, die dazu beiträgt, die Leistungsfähigkeit, Zuverlässigkeit und Benutzerfreundlichkeit der Komponenten zu verbessern.

Herkömmliche Bildverarbeitungssoftware bezieht sich auf diskrete, regelbasierte Algorithmen, die eine erhebliche Menge automatisierter Bildverarbeitungsaufgaben ausführen können. Beispiele für allgemeine Bildverarbeitungsalgorithmen sind Kantenerkennung, Bildtransformation, Inhaltsstatistik, Korrelation, geometrische Suche, OCR/OCV und Korrelation. Wenn es darum geht, Deep Learning in ein Bildverarbeitungssystem zu integrieren, ist es wichtig zu bedenken, dass Deep Learning nicht in allen Bildverarbeitungsanwendungen eingesetzt werden kann.

In bestimmten Anwendungen kann Deep Learning natürlich die Lücken schließen, die herkömmliche Ansätze möglicherweise nicht bieten. Beispielsweise sucht ein Bildverarbeitungssystem, das eine Schweißnaht prüft, nach bestimmten Details im Bild der Schweißnaht. Da jedoch jede Schweißnaht einzigartig ist, ist es für die Software schwierig, sie algorithmisch zu definieren. Deep Learning hingegen kann eher subjektive Merkmale identifizieren, ähnlich wie eine Person eine Schweißnaht prüfen würde. Eine leicht amorphe Schweißnaht, die nicht wie ein goldenes Bild aussieht, ist nicht unbedingt gleichbedeutend mit einer fehlerhaften Schweißnaht.

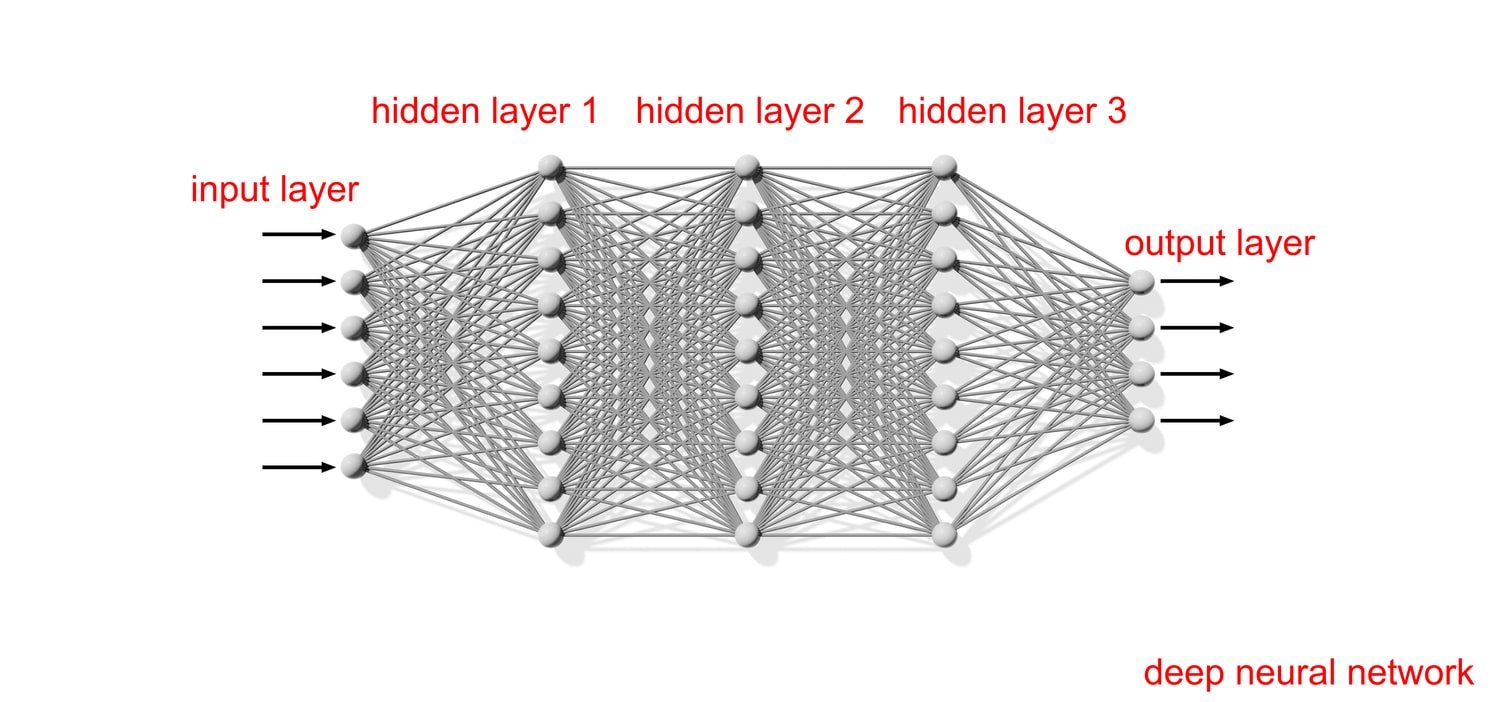

Feige 1: Neuronale Netze sind dem menschlichen Gehirn nachempfunden und stellen eine Teilmenge des maschinellen Lernens dar, die das Herzstück von Deep-Learning-Algorithmen bildet und es einem Computer ermöglicht, anhand von Trainingsbeispielen zu lernen, bestimmte Aufgaben auszuführen.

Damit Deep Learning erfolgreich sein kann, ist die Erstellung eines qualitativ hochwertigen Datensatzes erforderlich. Hersteller können einen ersten Datensatz erstellen, indem sie zusammen mit den „guten Bildern“ Bilder hochladen, die Fehlerklassen oder Merkmale darstellen, die erkannt werden müssen. Ein Team aus Fachexperten kann den Ausgangsdatensatz kennzeichnen und das Modell trainieren, Ergebnisse mit Testbildern aus dem Originaldatensatz validieren, die Leistung in der Produktion testen und das Modell neu trainieren, um alle neuen Fälle, Funktionen oder Mängel abzudecken. Sobald dies erledigt ist und alle Faktoren für die Implementierung von Deep Learning in ein Bildverarbeitungssystem berücksichtigt wurden, kann die Software bei der Fehlererkennung, Merkmalsklassifizierung und Montageverifizierung sowie bei der Inspektion komplexer oder sehr variabler Szenen helfen Das Erkennen spezifischer Merkmale kann sich als schwierig erweisen, z. B. beim „Bin Picking“ bei gemischten Teilen oder Produkten.

ÜBERLEGUNGEN ZUR DEEP-LEARNING-KAMERA

Auch wenn es vielleicht ein Klischee ist, stimmt es doch, dass es bei der Entwicklung einer Deep-Learning-Anwendung heißt: „Müll rein, Müll raus.“ Wie herkömmliche Bildverarbeitungsansätze können Deep-Learning-Anwendungen schlechte Beleuchtung oder optisches Design nicht überwinden und erfordern dennoch qualitativ hochwertige Bilder, um einen hochwertigen Datensatz für Training und Kennzeichnung zu erstellen. Dies bedeutet, dass entweder ein optimales Beleuchtungssetup implementiert werden muss, um einen ausreichenden Kontrast auf den Bildern zu erzielen, oder in manchen Fällen ein spezielles Beleuchtungsschema. Beispielsweise erfordern bestimmte Anwendungen möglicherweise mehrere Inspektionen an einem einzelnen Teil, was unterschiedliche Beleuchtungseinstellungen für Dinge wie An-/Abwesenheit oder die Überprüfung der Größe oder Form eines Objekts erfordert.

Während die Beleuchtung bei jeder Bildverarbeitungs- oder Deep-Learning-Anwendung entscheidend für den Erfolg ist, dreht sich das System natürlich um die Fähigkeit der Kamera, Bilder mit der erforderlichen Geschwindigkeit und Auflösung aufzunehmen. Bilder müssen die richtige Auflösung für die Zielanwendung mit dem bestmöglichen Funktionskontrast haben – es müssen jedoch auch mehrere andere Anwendungseinschränkungen und Überlegungen berücksichtigt werden. Dazu gehören Größe, Gewicht, Leistung, Geschwindigkeit des abzubildenden Objekts, Streaming vs. Aufzeichnung , Farbe vs. Monochrom, minimale Fehlergröße und minimales Sichtfeld.

Hochgeschwindigkeitsanwendungen, bei denen sich ein Teil oder Motiv sehr schnell bewegt und das System die Aktion des Objekts einfrieren muss, um Details zu analysieren, erfordern Kameras mit höherer Geschwindigkeit, während ein System, das hohe Detailgenauigkeiten erfordert, eine Kamera mit hoher Geschwindigkeit erfordert. Bildsensor mit hoher Auflösung. Emergent Vision Technologies ist auf das Design und die Entwicklung von Industrieprodukten spezialisiert Hochgeschwindigkeitskameras die einige der höchsten Bildraten und Auflösungen liefern, die heute auf dem Bildverarbeitungsmarkt verfügbar sind.

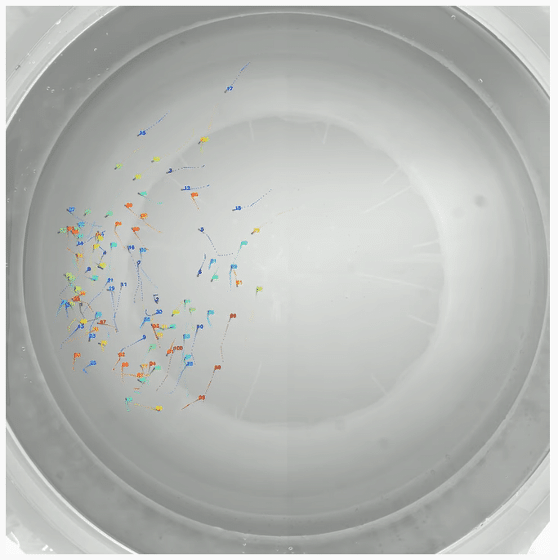

Feige 2: Das Tool intracker.ai identifiziert und verfolgt die Position einzelner, nicht markierter Tiere, unabhängig von der Art oder Größe der Tiere. In dieser Anwendung verwendeten die Forscher 20MP 10GigE-Kameras von Emergent, um ein Kollektiv von 100 jungen Zebrafischen mit einer Genauigkeit von 99.9 % zu verfolgen.

Das Bewährte nutzen GigE-Vision und GenICam-Standards, Emergent Bildverarbeitungskameras können nahtlos in kompatible Softwareanwendungen integriert werden, ohne dass proprietäre Erfassungshardware oder Verkabelung erforderlich ist. Aufsteiger 10GigE, 25GigE und 100GigE-Kameras bieten Auflösungen über 100 MP+ und Bildraten nahe 3500 fps für Anwendungen, bei denen große Datenmengen generiert und dann schnell und zuverlässig an ein Host-Gerät wie einen Industrie-PC übertragen werden müssen.

Durch die Verwendung von Ethernet als Konnektivitätsschnittstelle liefern Emergent-Kameras Konnektivitätsgeschwindigkeiten von bis zu 100 Gbit/s, ohne dass die Sensorauflösung oder -geschwindigkeit darunter leidet. Darüber hinaus können die Kameras mithilfe von IEEE1588 PTP synchronisiert werden, um eine Hochgeschwindigkeitsbilderfassung eines Ereignisses in weniger als 1 µs ohne CPU-Auslastung und mit absolut minimaler CPU-Auslastung, Speicherbandbreite, Latenz und Jitter bei Kabellängen von bis zu 10 km zu ermöglichen.

INFERENZ

Das folgende Video zeigt, wie einfach man sein eigenes trainiertes Inferenzmodell hinzufügen und testen kann, um die Erkennung und Klassifizierung beliebiger Objekte durchzuführen. Trainieren Sie Ihr Modell einfach mit PyTorch oder TensorFlow und fügen Sie es Ihrem eigenen eCapture Pro-Plug-in hinzu. Instanziieren Sie dann das Plug-in, verbinden Sie es mit der gewünschten Kamera und klicken Sie auf „Ausführen“ – einfacher geht es nicht.

Mit gut trainierten Modellen können Inferenzanwendungen mithilfe der GPU Direct-Funktionalität von Emergent mit vielen Emergent-Kameras auf einem einzigen PC mit einigen GPUs entwickelt und bereitgestellt werden – niemand bietet Leistungsanwendungen wie Emergent.

KUNDENSPEZIFISCHE PLUG-IN-ENTWICKLUNG

In diesem kurzen Clip veranschaulichen wir den Prozess, bei dem Kunden ihre eigenen benutzerdefinierten Plug-Ins erstellen können, die anschließend in eCapture Pro geladen und Echtzeitergebnisse generiert werden können. Wir weisen darauf hin, dass jedes Plug-in an eine oder mehrere Kameras angeschlossen werden kann, um den gesamten Systemdurchsatz zu testen und so eine maximale Systemdichte zu erreichen.

GPUDIRECT: BILDVERLUST OHNE DATENVERLUST

Viele Anwendungen verlassen sich heute bei Deep-Learning-Aufgaben auf NVIDIA-GPUs, um den Rechenleistungsbedarf zu decken. Die Bildverarbeitungskameras von Emergent sind auch mit NVIDIA kompatibel GPUDirect Technologie, die die Übertragung von Bildern direkt in den GPU-Speicher ermöglicht. Für einen aufstrebenden Kunden, der die GPUDirect-Technologie nutzt, bedeutete dies die Bereitstellung eines darauf basierenden Systems Bolt HB-12000-SB 25GigE-Kameras, ein Server und eine CPU, zwei Dual-Port 100G Netzwerkschnittstellenkarten (NICs), ein 24-fach-Port-Switch und zwei NVIDIA-GPUs.

In diesem System war der Kunde rund um die Uhr im Einsatz HB-12000-SB-Kameras, die mit dem 12.4 MP Sony Pregius S IMX535 ausgestattet sind, Bilder mit 60 Bildern pro Sekunde aufnehmen und die Daten direkt an die GPUs senden, was zu … Bildgebung ohne Datenverlust ohne CPU-Auslastung und ohne Speicherbandbreite. Mit H.265 KompressionsDie Bilder können auch lokal auf der Festplatte gespeichert und an RTMP-Clients (Real-Time Messaging Protocol) wie YouTube gestreamt werden. Durch den Einsatz innovativer Verarbeitungstechnologien wie GPUDirect können Endbenutzer große Datenmengen schnell und effizient erfassen, übertragen und verarbeiten, ohne sich Gedanken über den Verlust von Frames machen zu müssen.

EMERGENT GIGE VISION-KAMERAS FÜR KI- UND DEEP-LEARNING-ANWENDUNGEN

| Modell | Chroma | Auflösung | Frame Rate | Schnittstelle | Sensorname | Pixel Größe | |

|---|---|---|---|---|---|---|---|

|

HR-1800-SM | Mono | 1.76MP | 660fps | 10GigE SFP+ | Sony IMX425 | 9 × 9 μm |

|

HR-1800-SC | Farbe | 1.76MP | 660fps | 10GigE SFP+ | Sony IMX425 | 9 × 9 μm |

|

HR-5000-SM | Mono | 5MP | 163fps | 10GigE SFP+ | Sony IMX250LLR | 3.45 × 3.45 μm |

|

HR-5000-SC | Farbe | 5MP | 163fps | 10GigE SFP+ | Sony IMX250LQR | 3.45 × 3.45 μm |

|

HR-12000-SM | Mono | 12MP | 80fps | 10GigE SFP+ | Sony IMX253LLR | 3.45 × 3.45 μm |

|

HR-12000-SC | Farbe | 12MP | 80fps | 10GigE SFP+ | Sony IMX253LQR | 3.45 × 3.45 μm |

|

HR-25000-SB-M | Mono | 24.47MP | 51fps | 10GigE SFP+ | Sony IMX530 | 2.74 × 2.74 μm |

|

HR-25000-SB-C | Farbe | 24.47MP | 51fps | 10GigE SFP+ | Sony IMX530 | 2.74 × 2.74 μm |

Weitere Kameraoptionen finden Sie in unserem interaktives Systemdesigner-Tool.