EINSATZ VON MACHINE VISION FÜR DIE INSPEKTION UND SORTIERUNG VON AUTOTEILEN

Bildverarbeitungssysteme dienen der Automobilindustrie seit langem in fast allen Aspekten des Produktionsprozesses, indem sie die Qualitätskontrolle verbessern und Herstellungsprozesse rationalisieren. Aufgrund der äußerst individuellen Anforderungen der Automobilfertigung müssen Bildverarbeitungssysteme so konzipiert sein, dass sie mehrere verschiedene Arten von Fehlern innerhalb einer einzelnen Unterbaugruppe aufdecken.

Die Bildverarbeitungstechnologie bietet überzeugende Vorteile gegenüber der menschlichen Inspektion, insbesondere wenn die Qualität im gesamten Inspektionsprozess der Automobilfertigung sichergestellt werden muss. Paarung Bildverarbeitungskameras und Technologien mit Robotern schafft ein System, das in der Lage ist, Komponenten auch bei Positionsunsicherheit und verwirrenden Hintergründen zu sortieren und zu prüfen. Ein Beispiel, das sich besonders gut für kleine Bauteile eignet, ist eine Inspektionsstation mit mehreren Kameras und mehreren Positionen in einem visiongesteuerten Teileaufnahmeprozess aus einem flexiblen Feeder mit Nahbereichsprüfung in einer speziellen Anlage.

Anwendungen

AUTOMATISIERTE INSPEKTION > MANUELLE INSPEKTION

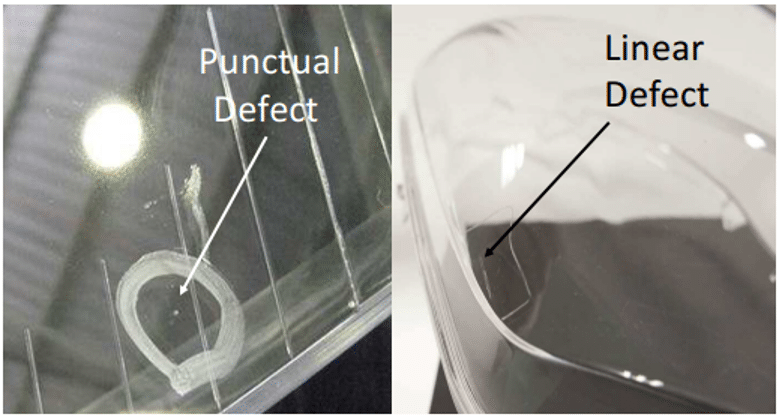

Beginnen wir mit einem einfachen, einzelnen Automobilteil, das automatisch auf Oberflächenfehler untersucht wird: dem Autoscheinwerferglas1. In vielen Produktionsstätten werden Scheinwerfer einer manuellen Inspektion durch einen Bediener unterzogen, der sie unter besonderen Lichtbedingungen auf Fehler prüft, die größer als 0.5 mm sind.

Defekte, die die gleichen optischen Eigenschaften wie eine makellose Oberfläche der Linse haben, sind schwieriger zu erkennen. Abb.. 1

Abb.. 1 Dieses Bild zeigt einige defekte Scheinwerfergläser (Bild mit freundlicher Genehmigung von Referenz 1)

Die größten Nachteile eines manuellen Inspektionsprozesses sind der erhöhte Zeitaufwand sowie die Notwendigkeit, mit einer breiten Palette an Objektivmodellen zu arbeiten. Um in einer realen industriellen Produktionsumgebung effizienter zu sein, benötigt ein Hersteller:

- Zuverlässige Fehlererkennung

- Echtzeitinspektion innerhalb eines bestimmten Zeitraums

- Ein System, das an die Inspektion verschiedener Linsenmodelle angepasst werden kann

MACHINE VISION INSPEKTION VON KLEINEREN AUTOMOBILKOMPONENTEN

Um die Inspektion der gesamten Scheinwerferlinse unter Berücksichtigung der kleinsten Fehlergröße und auch der Zykluszeit sicherzustellen, muss das Bildverarbeitungssystem eingesetzt werden mehrere Kameras. Beispielsweise verfügt das in Referenz 1 hervorgehobene Inspektionssystem über neun Bildverarbeitungskameras mit der Möglichkeit, die Position der Linsen in Bezug auf diese Kameras zu ändern.

Visiongesteuerte Robotersysteme für kleine Artikel, insbesondere solche mit einer metallisch reflektierenden Oberfläche, stellen eine anspruchsvolle Qualitätskontrollaufgabe dar. Ein wichtiges Beispiel für kleine Automobilkomponenten ist KArtridgeTM Druckluftbremskupplungen. Diese Kupplungen verbinden Rohre innerhalb des Fahrzeugbremssystems. Kongsberg Automotive AS verfügt über eine Multimaterial-Produktkupplung aus Verbundwerkstoff, Metall und Gummi. Eine sehr wichtige Komponente dieser Kupplungen ist die Sternscheibe, ein Allzweck-Metallteil, das den Halt zwischen einer Kupplung und ihrem Gehäuse sicherstellt.

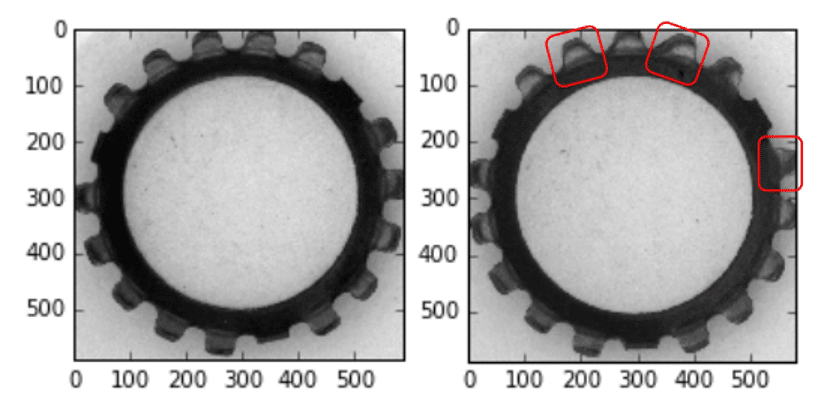

Abb.. 2 zeigt hervorragende Beispiele sowohl einer guten als auch einer defekten Sternscheibe.

Abb.. 2 Dieses Bild zeigt eine gute Zahnscheibe (links) und eine defekte Zahnscheibe (rechts) mit verschiedenen Mängeln in der Zahngeometrie. (Bild mit freundlicher Genehmigung von Referenz 2)

Bildverarbeitungssysteme werden aufgrund des natürlichen Reflexionsvermögens der metallischen Oberfläche der Sternscheiben und der Farbvariabilität von Charge zu Charge vor Herausforderungen stehen. Die geringe Größe dieser Art von Komponenten macht die Teileprüfung für die Kameras und die Beleuchtungseinrichtung schwierig.

Die maschinengesteuerten Aufgaben werden sein:

- Identifizierung von Sternscheiben am Vorschubmechanismus

- Klassifizierung der Sternscheibenorientierung

- Segmentierung der Zähne der Sternscheibe zur Inspektion aus nächster Nähe

AUTOMOBILINSPEKTIONSKAMERAS

Emergent Vision Technologies verfügt über eine umfangreiche Palette an Kameraoptionen für die automatisierte Inspektion und Sortierung, darunter 10GigE, 25GigE, und 100GigE-Kameras im Bereich von 0.5 MP bis 100 MP+. Diese Kameras verfügen alle über eine Reihe von Bildraten von bis zu 3462 Bildern pro Sekunde bei voller Auflösung von 2.5 MP, um unterschiedlichen Bildanforderungen gerecht zu werden.

Bestimmte Bildverarbeitungskameras, wie zum Beispiel RDMA-Kameras (Remote Direct Memory Access), eignen sich recht gut für die Inspektion von Automobilteilen. Diese Technologie ermöglicht die paketweise Übertragung von Daten zwischen Geräten in einem Netzwerk ohne CPU-Beteiligung. Kameras nutzen GPUDirect-Technologie ermöglichen auch die Übertragung von Bildern direkt in den GPU-Speicher, was mit erfolgen kann Neue eCapture Pro-Software. Durch den Einsatz dieser Technologie wird keine CPU-Auslastung und keine Speicherbandbreitenabbildung ohne Datenverlust erreicht.

ZELLENARCHITEKTUR DES MASCHINE-VISION-SYSTEMS

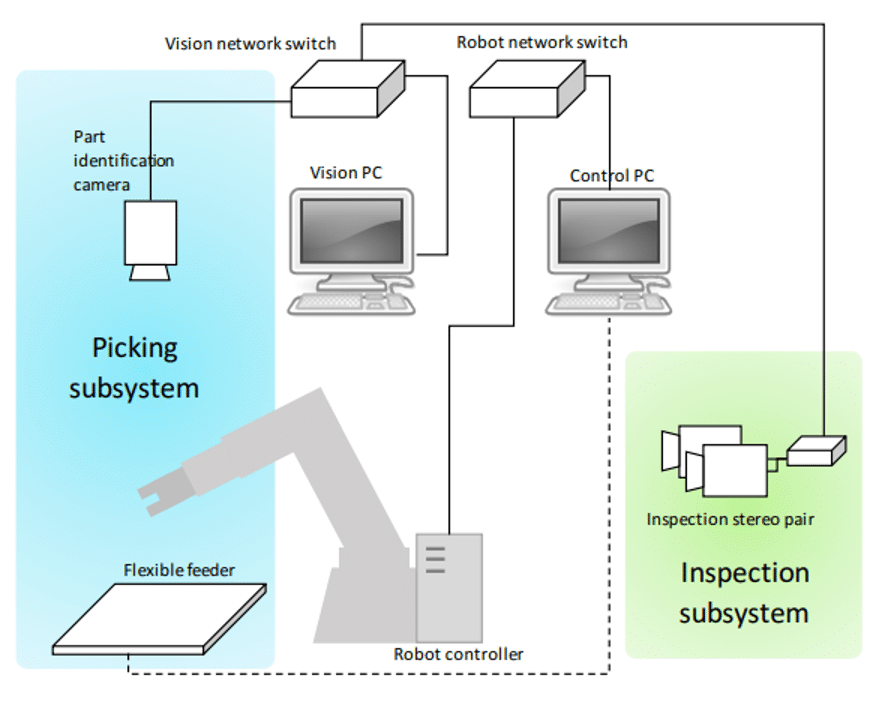

Abb.. 3 Dieses Bild zeigt die Kommunikationsarchitektur der Demonstratorzelle mit einer Adept Viper s850 Robotersteuerung (Bild mit freundlicher Genehmigung von Referenz 2)

Für die Teileauswahl und -manipulation ist ein Adept Viper s850 Roboter wurde für das in Abbildung 3 dargestellte System ausgewählt. Die Schnittstelle zur Robotersteuerung und die Roboterprogrammierung erfolgt über eine separate Desktop-Umgebung mit der Adept Desktop-Version 4.2.2.8, die auf einem dedizierten PC installiert werden kann. Die Programmierung erfolgt mit der proprietären V+-Sprache.

Die Teilezuführung erfolgte mittels eines Anyfeed SX240 flexibler Feeder. Dieser Feeder ist für die zufällige Zuführung der Teile konzipiert und kann mit einem Bildverarbeitungssystem zur Posenschätzung gekoppelt werden (a Computer Vision Aufgabe, bei der das Ziel darin besteht, die Position und Orientierung einer Person oder in diesem Fall eines Objekts zu ermitteln. Der Feeder kann über eine RS-232-Kommunikationsschnittstelle mit externen Systemen kommunizieren. Die Kommissionieroberfläche des Feeders verfügt zudem über eine Hintergrundbeleuchtung, was die Bildverarbeitung und Teileidentifizierung weiter vereinfacht.

GPUDIRECT: BILDVERLUST OHNE DATENVERLUST

Anstatt proprietäre oder Punkt-zu-Punkt-Schnittstellen und Bilderfassungskarten zu nutzen, nutzt Emergent die GigE-Vision Standard und die allgegenwärtige Ethernet-Infrastruktur für zuverlässige und robuste Datenerfassung und -übertragung mit erstklassiger Leistung. Emergent setzt eine optimierte GigE Vision-Implementierung ein und unterstützt Direktübertragungstechnologien wie NVIDIA GPUDirect, was die Übertragung von Bildern direkt in den GPU-Speicher ermöglicht. Die Technologie mildert die Auswirkungen großer Datenübertragungen auf die System-CPU und den Speicher und nutzt stattdessen eine leistungsfähigere GPU-Fähigkeit für die Datenverarbeitung, während gleichzeitig die Kompatibilität mit dem GigE Vision-Standard und die Interoperabilität mit kompatibler Software und Peripheriegeräten gewahrt bleiben.

MUSTERPASSEND

Das folgende Video zeigt, wie einfach man einen Algorithmus erstellen und prototypisieren kann, um einen qualitativ hochwertigen Mustervergleich durchzuführen, während man nur seinen benutzerdefinierten GPU-Cuda-Code schreibt.

INFERENZ

Das folgende Video zeigt, wie einfach man sein eigenes trainiertes Inferenzmodell hinzufügen und testen kann, um die Erkennung und Klassifizierung beliebiger Objekte durchzuführen. Trainieren Sie Ihr Modell einfach mit PyTorch oder TensorFlow und fügen Sie es Ihrem eigenen eCapture Pro-Plug-in hinzu. Instanziieren Sie dann das Plug-in, verbinden Sie es mit der gewünschten Kamera und klicken Sie auf „Ausführen“ – einfacher geht es nicht.

Mit gut trainierten Modellen können Inferenzanwendungen mit vielen entwickelt und bereitgestellt werden Neue Kameras auf einem einzelnen PC mit ein paar GPUs unter Verwendung der GPUDirect-Funktionalität von Emergent – niemand führt Leistungsanwendungen wie Emergent aus.

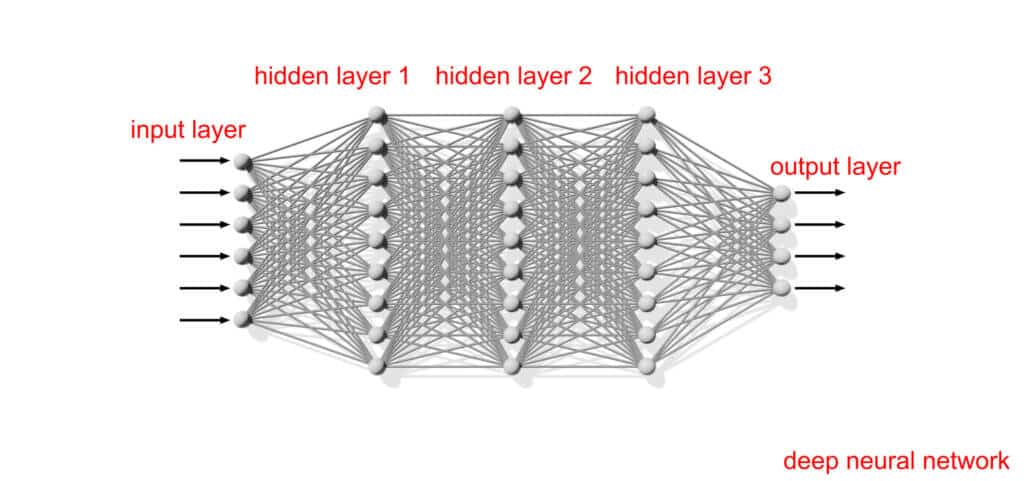

Feige 4: Neuronale Netze sind dem menschlichen Gehirn nachempfunden und stellen eine Teilmenge des maschinellen Lernens dar, die das Herzstück von Deep-Learning-Algorithmen bildet und es einem Computer ermöglicht, anhand von Trainingsbeispielen zu lernen, bestimmte Aufgaben auszuführen.

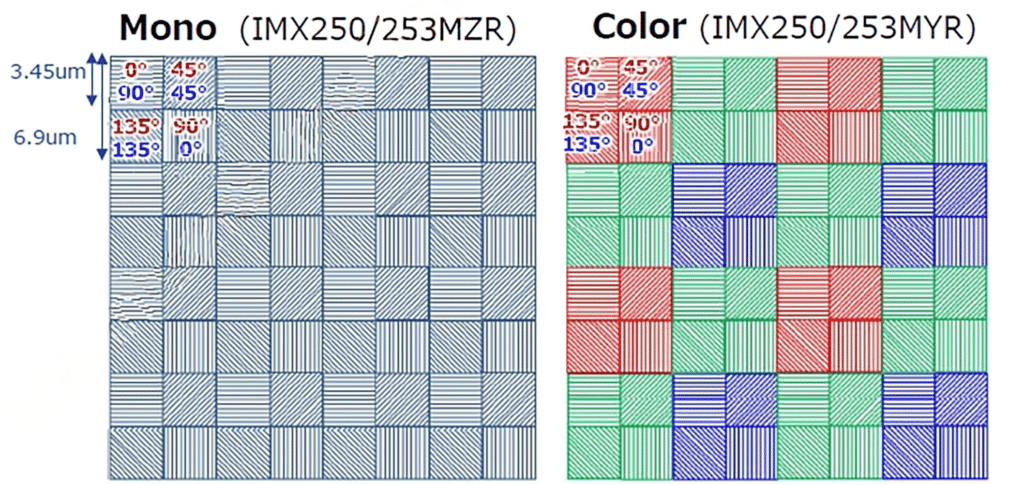

POLARISATION

Feige 5: In den CMOS-Polarisationssensoren von Sony PolarSens haben winzige Drahtgitterpolarisatoren über jeder Linse Polarisationswinkel von 0°, 45°, 90° und 135° in Vier-Pixel-Gruppen.

EMERGENT GIGE VISION-KAMERAS FÜR ANWENDUNGEN IN DER TEILEPRÜFUNG

| Modell | Chroma | Auflösung | Frame Rate | Schnittstelle | Sensorname | Pixel Größe | |

|---|---|---|---|---|---|---|---|

|

HR-5000-SM | Mono | 5MP | 163fps | 10GigE SFP+ | Sony IMX250LLR | 3.45 × 3.45 μm |

|

HR-5000-SC | Farbe | 5MP | 163fps | 10GigE SFP+ | Sony IMX250LQR | 3.45 × 3.45 μm |

|

HR-25000-SB-M | Mono | 24.47MP | 51fps | 10GigE SFP+ | Sony IMX530 | 2.74 × 2.74 μm |

|

HR-25000-SB-C | Farbe | 24.47MP | 51fps | 10GigE SFP+ | Sony IMX530 | 2.74 × 2.74 μm |

|

HB-65000-GM | Mono | 65MP | 35fps | 25GigE SFP28 | Gpixel GMAX3265 | 3.2 × 3.2 μm |

|

HB-65000-GC | Farbe | 65MP | 35fps | 25GigE SFP28 | Gpixel GMAX3265 | 3.2 × 3.2 μm |

Weitere Kameraoptionen finden Sie in unserem interaktives Systemdesigner-Tool.