사례 연구: 실시간 혼합 현실의 장벽을 허무는 고속 카메라

메타버스 라이브 스트리밍 회사인 Condense Reality가 Emergent 고속을 사용하여 혼합 현실 시스템을 한 단계 끌어올린 방법을 알아보세요. GigE 카메라 체적 캡처 시스템에서. Emergent 제품은 주로 메타버스 스포츠, 엔터테인먼트 및 라이브 이벤트 애플리케이션에서 사용됩니다.

일생에 한 번뿐인 콘서트에서 좋아하는 연주자 옆에 설 수 있다고 상상해 보세요. 매 경기마다 50야드 라인에 좌석을 예약하거나 스타 선수들이 골을 넣을 때 옆에서 "달릴" 기회가 있다고 상상해보세요. 리그 우승. 이제 거실에 앉아 있거나 바쁜 직장에서 집으로 통근하거나 최신 멀티플레이어 게임을 하면서 이러한 경험을 할 수 있다고 상상해 보십시오.

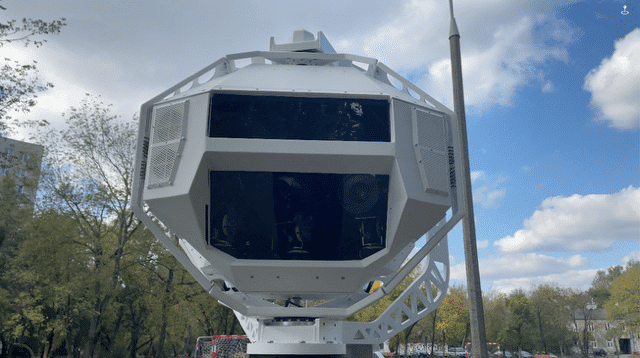

You-are-re-rere 경험은 몰입형 미디어가 실시간 혼합 현실(MR)로 제공할 것을 약속하는 것입니다. 이 새로운 형식은 이벤트가 발생할 때 체적 비디오 데이터를 사용하여 3차원(1D) 이미지를 생성합니다(그림 XNUMX). 또한 여러 사람이 다양한 장치에서 다양한 각도에서 이미지를 볼 수 있습니다.

현실을 3D로 캡처하는 것은 어렵습니다.

미디어 회사는 360도 비디오, 가상 현실(VR), 증강 현실(AR) 및 MR과 같은 기술 형식을 일찍 채택했습니다.

실시간과 달리 일반 MR은 3D에서 물리적 개체와 디지털 개체를 혼합하며 일반적으로 녹색 화면과 정밀하게 보정된 수백 대의 카메라가 있는 전용 공간에서 제작됩니다. 각 장면에서 캡처된 방대한 양의 볼륨 데이터를 처리하려면 몇 시간 또는 며칠의 후반 작업 시간이 필요합니다.

실시간으로 MR을 시도하는 것은 콘텐츠 개발자에게 기술적으로나 경제적으로 훨씬 더 어려운 것으로 입증되었으며 지금까지 형식을 비실용적으로 만들었습니다.

고속 이미징 카메라의 최고 제조업체인 Emergent Vision Technologies의 CEO이자 설립자인 John Ilett은 "많은 수의 카메라에서 고해상도, 높은 프레임 속도의 비디오를 캡처하고 동기화하는 것은 그 자체로 충분히 간단합니다."라고 말했습니다. . "라이브 장소에서 실시간으로 이 비디오를 처리하는 것은 정말 어려운 일입니다."

그림 1: Condense Reality는 Emergent Vision Technologies의 고속 GigE Vision 카메라를 사용하여 몰입형 혼합 현실 경험을 생성합니다.

딥 러닝에는 도움이 필요합니다

한 스타트업은 이러한 문제를 극복하기 위한 전략이 있다고 생각했습니다. 볼류메트릭 비디오 회사인 Condense Reality는 이미지를 캡처하고, 장면을 재구성하고, MR 콘텐츠를 여러 해상도로 최종 사용자 장치에 스트리밍할 계획을 가지고 있었습니다. 시작부터 끝까지 라이브 스트림의 각 프레임을 완료하는 데 밀리초만 필요합니다.

Condense Reality의 CEO인 Nick Fellingham은 "우리 소프트웨어는 장면에 있는 물체의 크기와 모양을 계산합니다."라고 말했습니다(그림 2). “카메라가 볼 수 없는 물체가 있으면 소프트웨어는 딥 러닝을 사용하여 공백을 채우고 필요하지 않은 것을 버린 다음 3D 모션 이미지를 전화기, 태블릿, 컴퓨터, 게임 콘솔, 헤드셋 및 스마트 장치로 스트리밍합니다. TV와 안경.”

그러나 문제가 발생했습니다. 소프트웨어가 실제 응용 프로그램에서 작동하려면 Fellingham은 콘텐츠 제작자가 스포츠 경기장, 콘서트장 또는 원격 위치에서 쉽게 설정할 수 있는 고해상도, 높은 프레임 속도의 카메라가 필요했습니다. 이 회사는 카메라를 테스트했지만 데이터 처리량과 카메라와 시스템의 데이터 처리 장치 사이의 케이블 거리가 심각하게 제한된 모델을 사용했습니다. 앞으로 나아가기 위해 Condense Reality는 대용량 데이터를 고속으로 처리할 수 있는 방송 품질의 카메라가 필요했습니다.

그림 2: Condense Reality CEO Nick Fellingham이 회사의 체적 캡처 설정 중 하나 안에 서 있습니다.

고속 카메라 제공

2020년에 Fellingham은 Emergent Vision Technologies가 고해상도 이미지 센서가 장착된 몇 가지 새로운 카메라를 출시한다는 사실을 알게 되었습니다. 이 카메라에는 SFP28-25GigE, QSFP28-50GigE 및 QSFP28-100GigE 모든 길이를 포괄하는 케이블링 옵션을 제공하는 인터페이스 옵션.

Ilett은 "우리 카메라는 고속 및 높은 데이터 속도로 고품질 이미지를 제공합니다."라고 말했습니다. "그들은 센서 기술의 발전을 활용하고 카메라가 센서의 전체 프레임 속도를 달성할 수 있도록 우리가 개발한 펌웨어를 통합합니다."

MR 경험의 이미지는 매우 높은 프레임 속도와 해상도로 캡처해야 합니다. 새 카메라로 Fellingham은 상업적으로 실행 가능한 시스템을 조립할 수 있었습니다. "고속 GigE 카메라는 카메라에서 신속하게 데이터를 가져와 스트리밍하는 데 필요한 것입니다."라고 그는 말했습니다.

고속 캡처는 말 그대로 눈 깜짝할 사이에 흥미진진한 동작이 자주 발생하는 스포츠에 특히 중요합니다. 예를 들어 골프 스윙을 캡처할 때 프레임 속도가 30fps인 카메라는 스윙의 시작과 끝만 "볼" 가능성이 높기 때문에 볼륨 콘텐츠의 품질이 크게 떨어집니다.

“우리는 공장에서 부품을 검사하기 위해 이 카메라를 사용하지 않습니다. 엔터테인먼트 경험을 창출하는 데 사용하고 있습니다.”라고 Fellingham은 말했습니다. "속도[fps]가 증가하면 빠르게 움직이는 동작의 품질이 향상되고 생성되는 출력이 향상되며 전반적인 경험이 향상됩니다."

더 큰 캡처 영역이 지평선에 있습니다

Condense Reality는 고객 프로젝트의 시스템 통합자 역할을 합니다. 표준 시스템은 32대의 카메라, Mellanox의 고속 네트워크 스위치 7개, NVIDIA의 단일 그래픽 처리 장치(GPU)를 사용하여 7m x XNUMXm 캡처를 처리합니다. 이 회사는 Emergent Vision Technologies와 협력하여 체적 캡처를 위한 최적의 시스템을 구성했습니다.

"우리는 반드시 매우 특정한 하드웨어 구성에 전념하기를 원하지는 않지만 Emergent 팀과 협력하고 다양한 구성 요소를 테스트함으로써 NVIDIA와 Mellanox가 우리에게 가장 적합하다는 것을 알게 되었습니다."라고 Fellingham은 말했습니다.

기술 구현과 함께 회사는 처리량과 품질을 유지하면서 MR의 캡처 영역을 늘리기 위해 노력하고 있습니다.

Fellingham은 “10 x 10미터 영역보다 커지기 시작하면 4K 카메라는 이를 잘라낼 수 없습니다. "알고리즘이 개선되면 더 커질 것입니다."

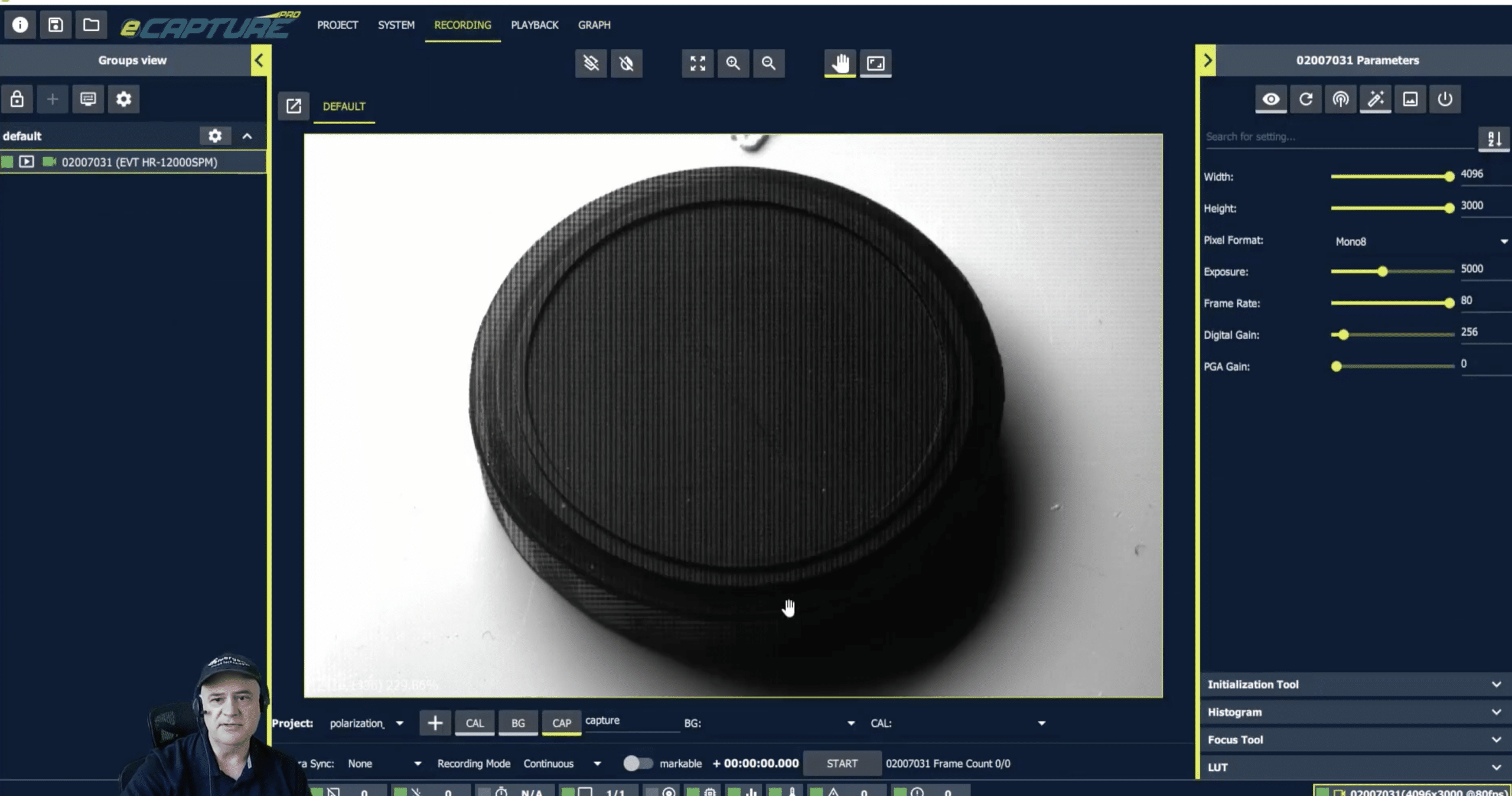

새로운 Emergent Vision Technologies 카메라는 이 작업에 필수적입니다. 모델 지원 최대 600 fps 5120 x 4096 해상도와 최대 100GigE 범위의 인터페이스 옵션에서 Fellingham은 카메라 해상도, 데이터 속도 또는 프레임 속도의 제한에 대해 걱정할 필요가 없었습니다. 이러한 이점은 Condense Reality가 더 나은 콘텐츠와 사용자 경험을 제공할 수 있는 좋은 위치에 있다는 것을 의미합니다.

소프트웨어: The Secret Sauce

Condense Reality의 소프트웨어는 수십만 개의 다각형으로 구성된 3D 메시를 생성하는 완전히 독점적인 제품입니다. 개체에 배치된 노드는 캡처되는 개체의 표면을 나타냅니다. 그런 다음 소프트웨어는 카메라에서 수집한 데이터로 메시를 "페인트"합니다. 그런 다음 이 데이터는 딥 러닝을 사용하여 카메라가 다루지 않은 물체의 부분을 추정합니다. 그런 다음 압축 알고리즘은 메시를 모든 프레임에 대해 가능한 한 작은 크기로 줄인다고 Fellingham은 말했습니다.

"이 소프트웨어는 이 모든 데이터를 가져와 매우 빠른 속도로 3D 모델로 변환합니다. 이는 잘 최적화된 알고리즘, 신경망 및 NVIDIA GPU 덕분에 가능합니다."라고 그는 말했습니다. "대부분의 신경망은 TensorFlow를 기반으로 하지만 시스템에서 사용하는 신경망 중 일부는 매우 빠르게 실행되어야 하므로 GPU용으로 직접 작성됩니다."

그는 “우리의 신경망은 매우 특정한 문제를 해결하여 속도를 최적화할 때 도움이 됩니다. 최적화하기가 매우 어렵기 때문에 많은 추론을 수행하는 거대한 블랙 박스를 배포하지 않습니다.”

프로세스를 완료하기 위해 데이터는 Condense Reality의 클라우드 기반 배포 플랫폼으로 전송되며, 여기서 데이터를 가져와서 사용자 장치에 따라 스트림이 달라지도록 가변 비트 전송률에 넣습니다. 재생은 게임 엔진 내에서 이루어지므로 고객은 볼류메트릭 비디오를 중심으로 VR 또는 AR이 될 수 있는 맞춤형 경험을 구축할 수 있습니다. Condense Reality 시스템은 게임 엔진을 지원하기 때문에 콘텐츠를 다른 회사가 소유한 기존 게임 세계로 스트리밍할 수도 있습니다. 현재 이 소프트웨어는 Unity 및 Unreal 게임 엔진을 지원하지만 회사는 향후 등장하는 모든 새로운 게임 엔진용 소프트웨어용 플러그인을 구축할 계획입니다.

Fellingham은 “이러한 엔진은 실제로 상호 작용하는 3D 도구이므로 더 이상 게임 엔진이라고 부를 수 없습니다.”라고 말했습니다. "실제 콘텐츠를 이러한 도구로 라우팅하여 고객에게 사실적인 3D 대화형 경험을 제공합니다."

추가 정보

Emergent Vision Technologies의 고속 카메라:

https://emergentvisiontec.com/area-scan-cameras/